El Caso de Establecimientos Educacionales Chilenos Participantes de SEPA

Se vive en la actualidad en una época centrada en la necesidad que las organizaciones rindan cuentas de su quehacer (accountability). Las organizaciones educacionales no se encuentran exentas de esta exigencia y son objeto de numerosas evaluaciones externas a través de test estandarizados que buscan medir el proceso educacional. Los indicadores desarrollados a partir de las evaluaciones estandarizadas externas se encuentran en vías de ser cada vez más complejas y se han convertido en el reflejo del éxito de los establecimientos educacionales (Gareis, 2007; Koretz, 2008). Pese a ello la introducción de indicadores, no siempre contribuye directamente al mejoramiento de las prácticas educativas. A diferencia de lo que tradicionalmente se cree, la traducción de los resultados de evaluaciones externas en acciones concretas de mejoramiento es un proceso complejo, no lineal y cuyas implicancias son diversas.

En el presente trabajo, se desarrolla una investigación que indaga sobre las diversas formas en que se puede utilizar información evaluativa y los factores que facilitan y dificultan su uso, en un grupo de establecimientos educacionales que participan del Sistema de Evaluación de Progresos del Aprendizaje (SEPA), desarrollado e implementado por el Centro de Medición de la Pontificia Universidad Católica de Chile (www.sepauc.cl).

SEPA es un sistema de evaluación externo y consiste en un conjunto de pruebas que evalúan los aprendizajes logrados por alumnos de 1º a 8º año básico en Lenguaje y Matemática. Los clientes de SEPA son mayormente colegios individuales, o grupos de colegios asesorados y/o administrados por fundaciones. Las pruebas SEPA incluyen preguntas de alternativas múltiples que son corregidas por el Centro para mantener su confidencialidad, y de desarrollo que son corregidas por los profesores apoyados por una rúbrica.

Los resultados son reportados a través de una página web (http://reportes.sepauc.cl) a la cual tienen acceso los clientes y actores de los establecimientos en los que se aplica SEPA. La presentación de resultados permite a cada colegio compararse con otros, resguardando su identidad. Los resultados incluyen:

(a) Los logros de aprendizaje (o el “estado” del aprendizaje) por subsector evaluado (Lenguaje y/o Matemática), por ejes temáticos (áreas de contenido mínimo obligatorio definidas por Marco Curricular) para el establecimiento, nivel, curso y alumno.

(b) Si el establecimiento permanece más de un año en SEPA, se le informa respecto del “progreso” de aprendizaje entre dos años evaluados, a nivel de establecimiento, nivel, curso y alumno, brindando una visión longitudinal acerca del desarrollo del alumno.

(c) Finalmente, a establecimientos con datos longitudinales, se les proporciona también índices de “valor agregado” para cada nivel evaluado. El valor agregado se obtiene a partir de una sofisticada técnica estadística que permite trazar la trayectoria de los aprendizajes en el tiempo y establecer el aporte efectivo que el colegio hace a ellos.

A través de SEPA, se espera que los establecimientos puedan disponer de información técnicamente validada que les permita monitorear sus resultados, y tomar decisiones de focalización de acciones pedagógicas a partir de las fortalezas y debilidades reportadas por la evaluación. Se anticipa que los datos proporcionados pueden ser utilizados para una diversidad de tareas, como por ejemplo, para el diseño o selección de actividades de capacitación para los profesores, modificación de planificaciones y estrategias pedagógicas empleadas en cada curso de acuerdo al perfil de rendimiento de sus alumnos, o desarrollo de actividades que atienden a las necesidades de alumnos particulares.

El sistema busca combinar las bondades de la rigurosidad que brinda la implementación de un sistema de evaluación externo a través de pruebas estandarizadas con la posibilidad que sean los actores escolares los que analicen e interpreten la información, y tomen las decisiones que estimen pertinentes según los procesos que estén dentro sus posibilidades. A través de este diseño se pretende que SEPA no sea percibido como amenazante y gatille respuestas defensivas en los destinatarios. Por otra parte, la regularidad con que se levanta la información (una vez al año) y el nivel de desagregación con que se entregan los resultados (por nivel, curso, alumno, subsector y eje temático) busca facilitar el hecho que la información pueda ser utilizada con fines formativos.

El artículo está estructurado de la siguiente manera: Primero revisamos la literatura relevante a nivel internacional respecto a la evaluación educacional, sus formas de uso, y factores que dificultan el uso de evaluaciones educacionales externas con fines formativos. Seguimos con la descripción del problema de investigación y de la metodología del estudio. Finalmente, se presentan los resultados y conclusiones del trabajo.

1. Revisión de la literatura

1.1. Distinciones importantes en la evaluación educacional

El proceso de enseñanza-aprendizaje es un proceso interactivo que requiere que los profesores tengan una idea de cómo progresan sus estudiantes y cuáles son las dificultades que enfrentan de modo de adaptar su trabajo a estas necesidades. En este proceso, la evaluación es esencial. La evaluación se refiere a todo proceso que genera información que puede ser utilizada para retroalimentar la práctica (Wiliam y Black, 1998). En este sentido Scriven (1967), diferencia entre las evaluaciones sumativas y las evaluaciones formativas.

El tipo de evaluación más conocido, es la evaluación sumativa. Las evaluaciones sumativas se desarrollan con el objetivo de medir que es lo que los estudiantes han aprendido al final de una unidad, para promover a los estudiantes de curso y para asegurarse que estos hayan cumplido con los requisitos mínimos para merecer una determinada certificación. Las evaluaciones sumativas se utilizan para producir información comparativa entre establecimientos en diversos contextos (Wiliam y Black, 1996). En un contexto de presión por que establecimientos educacionales demuestren resultados, las evaluaciones sumativas son crecientemente utilizadas para promover su responsabilización (“accountablity”) por estos (OECD, 2005). Sin embargo, el hecho se reciban resultados provenientes de evaluaciones sumativas, no quiere decir que estos sean utilizados para tomar decisiones orientadas al mejoramiento del desempeño de la organización. Por otra parte las evaluaciones se puede usar con fines formativos (OCDE, 2005), esto es, para redireccionar la gestión del establecimiento escolar.

La evaluación formativa, se refiere a un proceso interactivo y usualmente más frecuente, orientado a caracterizar el proceso y nivel de comprensión de los estudiantes de una materia determinada (OCDE, 2005; Ruiz-Primo y Furtak, 2006; Looney, 2007). A través de las evaluaciones formativas, se busca por ejemplo, que los profesores puedan ajustar sus estrategias de enseñanza en función de las necesidades emergentes de los estudiantes. A diferencia de la evaluación sumativa, más que para servir como indicador del desempeño de los estudiantes, la información producida busca ser utilizada para acomodar el proceso de enseñanza-aprendizaje (Wiliam y Black, 1998; Wiliam, Lee, Harrison y Black 2004; Wiliam, 2006). La evaluación formativa es considerada como una herramienta que permite mejorar efectivamente el desempeño en los estudiantes (Wiliam y Black, 1998; Wiliam, Lee, Harrison y Black 2004) y desarrollar sus habilidades de “aprender a aprender” (OCDE, 2005).

Desde el sentido común se esperaría que la información que produce una evaluación formativa fuese analizada por el equipo responsable del establecimiento y utilizada directamente para tomar decisiones orientadas a mejorar los aspectos críticos detectados. Este razonamiento supone que la entrega de información es un ejercicio neutro, que su interpretación será uniforme y que la entrega de esta información no producirá consecuencias negativas para ninguno de los actores involucrados. Sin embargo, normalmente estos supuestos no se cumplen.

Otra distinción relevante en torno a los enfoques de evaluación educacional tiene que ver con quien está a cargo de esta o, en otras palabras, si el evaluador se encuentra dentro o fuera del programa o de la institución que será evaluado. Por un lado, los evaluadores externos no tienen ninguna relación permanente con el programa, por lo tanto no están subordinados a personas dentro de este. Su valor radica en que pueden ser independientes, por ende son más creíbles. En cambio en el caso de los evaluadores internos, se presume que están expuestos a ser presionados a hallar resultados positivos. Sin embargo las evaluaciones internas tienen una serie de ventajas, entre ellas, el que son menos amenazantes, permiten desarrollar la capacidad de auto-monitoreo de la organización, empodrándo a los actores escolares. También promueven la reflexión interna y permiten incorporar información relevante del contexto, siendo así de mayor utilidad para el programa o la institución evaluada (Nevo, 2001; McDowell, Smailes, Sambell, K., Sambell, A. & Wakelin, 2008). En cambio, si bien las evaluaciones externas suelen ser más creíbles, también tienen mayores dificultades para incorporar información contextual relevante (Nevo, 2001). Usualmente las evaluaciones sumativas están a cargo de personas externas al programa, mientras que las evaluaciones formativas suelen desarrollarse en forma interna. Sin embargo, en el caso de SEPA tenemos un sistema de evaluación externa, pero con un enfoque en un uso formativo de sus procesos y resultados.

Como se puede apreciar, la evaluación no es un proceso unívoco, pueden existir diversos enfoques evaluativos según la finalidad y la ubicación del evaluador. Estas distinciones son relevantes porque son opciones para la implementación de evaluaciones en el ámbito educacional e influyen en la relación que establecen las organizaciones con la información evaluativa.

1.2. Formas de uso de la evaluación

Una larga tradición de investigación en el uso de información evaluativa sugiere que la relación entre el input de información sobre el desempeño y su uso para la toma de decisiones no es lineal, y que los posibles usos de la información son múltiples (Shula y Cousins 1997; Weiss, 1998; Alkin & Taut, 2003).

En este sentido Shula y Cousins (1997) estiman que es un error ignorar que el conocimiento es socialmente construido, y por ende inextricablemente ligado al contexto. Los autores observan que ante la entrega de información evaluativa, un destinatario tiene múltiples posibilidades de respuesta. Este puede optar por utilizar la información evaluativa entregada, abstenerse de utilizarla justificadamente, utilizarla en forma malintencionada (“misuse”), utilizarla en forma equivocada (por ejemplo usando datos de mala calidad) y utilizarla en forma abusiva (por ejemplo omitiendo la calidad de los datos para fines políticos). Los autores indican, que si bien desde una perspectiva externa el mal uso de la información parece ser algo reprobable, en la medida que se toma en cuenta el contexto, resulta cada vez más complejo hacer juicios taxativos sobre lo que es un buen o un mal uso.

Por su parte Weiss (1998), señala que no solamente es posible utilizar múltiples aspectos de una evaluación particular, sino que también se pueden utilizar las señales producidas por el mismo hecho de evaluar. El “usar” una evaluación implica considerar múltiples efectos posibles para múltiples usuarios de esta información. El fenómeno del uso puede ser muy complejo y cambiar para cada contexto organizacional. En este sentido Rich (1977) distingue el uso instrumental del uso conceptual. El uso instrumental refiere al uso tradicional, donde la información proporcionada es utilizada directamente para tomar decisiones. Según Weiss (1998) el uso instrumental se ve facilitado cuando los resultados son poco controvertidos, cuando los cambios sugeridos se encuentran dentro del repertorio de las posibilidades de acción de la organización y el ambiente del programa es relativamente estable o cuando la organización está en crisis. Por otra parte, el uso conceptual se refiere al uso de la información evaluativa con la finalidad de ampliar la comprensión de un problema determinado, pero no necesariamente para producir consecuencias concretas. Weiss (1998) extiende esta diferenciación, distinguiendo además el uso como herramienta de persuasión, es decir se utilizan los resultados para movilizar apoyo a una posición que ya se tiene sobre los cambios que se requiere implementar.

Finalmente Owen y Rogers (1999), distinguen entre el uso para legimitación (“legitimative use”) y el uso simbólico (“symbolic use”). En el primer caso, los resultados de la evaluación se utilizan para respaldar o legitimar decisiones previamente tomadas, usualmente para demostrar que estas eran las correctas. Por otra parte, el uso simbólico busca legitimar acciones previas sin necesariamente referirse a los resultados de la evaluación. En este caso, la evaluación puede conducirse, por ejemplo como un acto simbólico que busca mejorar la imagen de la institución o del tomador de decisiones.

Los tipos de uso están anclados en el contexto de la organización destinataria de la información, por lo que sus características son fundamentales para comprender sus formas de uso. Por ello un evaluador debe ser sensible a las preocupaciones de las personas que están en los programas que evalúan (Weiss, 1998) y preocuparse por ayudarlos a interpretar los resultados. Pese a que hay factores fuera del control del evaluador, este tiene la responsabilidad de hacer lo posible por asegurar la utilidad y facilitar el uso de las evaluaciones que conduce (Joint Committee on Standards for Educational Evaluation, 1994).

Así como se ha podido observar, la información evaluativa puede ser utilizada de múltiples formas y finalidades. El uso instrumental para tomar decisiones con el fin de mejorar la calidad de los procesos de enseñanza aprendizaje es solamente uno de los usos posibles. El evaluador debe estar consciente de la multitud de usos, siempre tomando en cuenta el contexto en que opera.

1.3. Factores que dificultan el uso de la evaluación

Entendiendo que existen numerosas formas en que se puede utilizar la información evaluativa, se han descrito determinados factores que puede facilitar u obstaculizar el su uso. Si bien la evaluación (sumativa o formativa), se ha reconocido como fundamental para la promoción del progreso del aprendizaje, el convertir los resultados evaluativos en practicas efectivas es un proceso que enfrenta numerosas dificultades (McDowell, Smailes, Sambell, Sambell, Wakelin, 2008; Wildawsky, 1972). La OCDE (2005) también reconoce que la evaluación formativa, pese a sus beneficios identificados, no es sistemáticamente practicada.

La introducción de un sistema de evaluación externa puede enfrentar resistencias que pueden frenar su uso, particularmente en el caso de los docentes. Se han descrito diversos factores asociados a la resistencia a la evaluación, tales como características del evaluado, por ejemplo: un menor número de años de formación, una mayor edad (Navarro, 2003) y el no haber tenido experiencias previas con evaluaciones externas (Donaldson, Gooler & Scriven, 2002; Taut & Brauns, 2003). Asimismo Funderburg y Levy (1997) plantean que aquellos individuos que tienen un locus de control interno, reciben de mejor manera la retroalimentación dado que la sienten más aplicable a su comportamiento. Asimismo la evaluación puede percibirse como una amenaza para la autoimagen del evaluado (Donaldson, Gooler & Scriven, 2002). Se puede percibir que las evaluaciones proveen retroalimentación respecto al mismo y no solamente sobre el desempeño (Taut & Brauns, 2003). Por otro lado, muchos sujetos se resisten porque experimentan temor debido a que se anticipan a posibles consecuencias negativas de los resultados evaluativos (Donaldson, Gooler & Scriven, 2002). La resistencia también se asocia a comportamientos del evaluador o características del entorno en el cual la evaluación tiene lugar, conocidos como factores situacionales. Entre estos se cuentan la preexistencia de una cultura contraria a la evaluación, la existencia de conflictos de poder e interés, y la desconfianza del instrumento, de las características del evaluador, de las estimaciones que este hará, o de la interpretación que se hará de los resultados (Taut y Brauns, 2003). Un tercer grupo de factores asociados a la resistencia, tienen que ver con la evaluación propiamente tal. Por un lado se encuentra la ambigüedad de rol entre los evaluadores y quien financia la evaluación (Donaldson, Gooler & Scriven, 2002), o la ambigüedad asociada al desconocimiento o ausencia de estándares de los niveles de desempeño (Milanowski & Heneman, 2001). La desconfianza puede manifestarse también como desacuerdo con el enfoque, método y prácticas evaluativas utilizadas (Navarro, 2003; Taut & Brauns, 2003).

La revisión de la literatura sugiere que el uso de la información evaluativa depende de una serie de factores entre los cuales se pueden mencionar los siguientes:

- Problemas de comprensión relativa al uso de datos cuantitativos. El tipo y la calidad de información proporcionada para establecer los logros académicos de los alumnos ha resultado ser un factor relevante para su uso. Antiguamente las decisiones sobre la orientación de los procesos de enseñanza y aprendizaje se solían tomar fundamentalmente basadas en el juicio profesional los actores escolares. Se asumía entonces que estos tenían la responsabilidad y el derecho a tomar decisiones sobre los estudiantes, escuelas y la educación en general. Para ello se basaban en una combinación de conocimiento tácito y privilegiado del contexto, la sabiduría política, la experiencia y el análisis lógico. En este contexto los datos no jugaban un rol relevante en la toma de decisiones. En la actualidad esto ha cambiado y la presión por rendir cuentas por las acciones de los establecimientos hace necesaria la producción y el uso de datos cuantitativos. Esto ha enfrentado a los actores escolares a la necesidad de poder comprender estos datos y tratar de darles sentido (Earl y Fullan, 2003).

Se ha observado que los actores escolares, aunque altamente motivados por el cambio, suelen mostrar bajas capacidades para interpretar y manejar datos cuantitativos (Earl y Fullan 2003; Taut, Cortés, Sebastian & Preiss, 2009). Esto sería aun más complejo en el caso del uso de índices de mayor complejidad como el valor agregado (Santelices & Taut, 2009). Aunque en estos estudios se valora y se percibe la información como claramente presentada, es al momento de la interpretación concreta donde se observan claras limitaciones de comprensión.

- Foco exclusivo en una evaluación solamente externa o interna. Fullan (2006) estima que la sola introducción de indicadores de logro del aprendizaje (externamente, por parte de la política educacional) no es suficiente para promover el cambio en establecimientos educacionales, porque suelen no tomar en cuenta las condiciones locales. Asimismo, este tipo de indicadores suelen estar diseñados para satisfacer las necesidades de información de tomadores de decisiones, no estándo conectados con lo que sucede al nivel del aula de clases, siendo poco informativos para los docentes.

Nevo (2001) postula que es necesario desarrollar un equilibrio entre evaluaciónes internas y externas. Si bien la introducción de sistemas de evaluación externa estimula el desarrollo de evaluaciones internas, el impacto de un sistema de evaluación externo depende de la existencia previa de una cultura de evaluación. Equipos acostumbrados a evaluarse, tendrán menos dificultades para comprender el significado y relevancia de una evaluación externa, y estar menos a la defensiva.

- Baja capacidad organizacional. Las organizaciones suelen responder a las evaluaciones con acciones que se encuentran ya dentro de su repertorio de acciones posibles y hasta entonces conocidas (Shula y Cousins, 1997), existiendo usualmente una brecha relevante entre lo que se sabe hacer y lo que debería hacerse para mejorar (Elmore, 2008). La capacidad de la organización (Fullan, 2002) está dada por elementos como el liderazgo del director, la orientación al desarrollo de habilidades de los docentes, la calidad de la comunidad profesional, la coherencia del programa académico y la disponibilidad de recursos técnicos. Fullan (2002) agrega que la mayor parte de las estrategias de mejoramiento escolar se orientan pobremente a la construcción de capacidad escolar. En este sentido Elmore (2008) agrega que el desarrollo de conocimientos y habilidades tanto individuales como colectivas es un proceso que ocurre en forma gradual y sin seguir una trayectoria lineal.

- Cultura de la evaluación. Un elemento relacionado con la capacidad organizacional, tiene que ver con lo que se ha denominado la “cultura de la evaluación” (OCDE, 2005). Una cultura de evaluación facilita el uso de las evaluaciones y la introducción de cambios consecuentes de mejoramiento. En una organización en la cual se puede observar una cultura de la evaluación, los actores escolares utilizan la información para generar conocimiento sobre que funciona y porque, comparten dicho conocimiento con sus colegas y se preocupan por desarrollar sus habilidades para abordar un rango cada vez más amplio de necesidades de aprendizaje de sus estudiantes. En estas la evaluación formativa es considerada como una herramienta para alcanzar metas de alto desempeño, equidad y enseñanza de habilidades de “aprender a aprender” (OCDE, 2005).

Scheerens (2004) propone que existen obstáculos cognitivos, emocionales, interpersonales, estructurales y procedurales que pueden dificultar el uso de resultados de evaluación interna para el aprendizaje organizacional. Por ejemplo, si la información ofrecida es vaga y carece de una retroalimentación instrumental a nivel de aula, y si además el propósito de la evaluación es de llegar a juicios en vez de una orientación a la tarea, se tiende a observar ausencia de aprendizaje a través de la evaluación. A nivel psicológico, el autor menciona la ansiedad frente la evaluación en combinación con un sentido de baja auto-eficacia como un escenario negativo (ver también Taut & Brauns, 2003). Finalmente, a nivel estructural-procedural, la baja transparencia en la entrega de información, el autoritarismo en la toma de decisiones, la insuficiencia de espacios para discutir en equipo los resultados, son obstáculos relevantes para el uso.

De lo anterior es posible destacar que el tipo de uso de información evaluativa se ve afectado por numerosas variables que no tienen que ver solo con la calidad técnica de la información o del diseño de evaluación mismo. Esas variables “extra técnicas” – sobre todo organizacionales – tienen un rol determinante en el modo en que se utilizará la información.

3. El problema de investigación

A partir de la literatura revisada, se espera que la introducción de SEPA enfrente dificultades respecto a su comprensión y uso por los establecimientos o fundaciones contratantes. La presente investigación tenía como objetivos (1) determinar el grado de comprensión de los conceptos de estatus, progreso, y valor agregado por parte de usuarios intencionados de SEPA; (2) describir el uso de los distintos tipos de información SEPA en los establecimientos participantes, en relación a su uso de prácticas evaluativas en general; (3) identificar las consecuencias de corto plazo de la entrega de la información SEPA; (4) identificar factores que facilitan o dificultan el uso de la información SEPA; y (5) formular recomendaciones que permitan mejorar el servicio de entrega de información SEPA.

Derivados de estos objetivos se buscó responder las siguientes preguntas de investigación:

- ¿Cuál es el grado de comprensión que tienen directivos y profesores respecto de los conceptos de estado, progreso y valor agregado?

- ¿Cuál es la utilidad percibida que tiene esta información para directivos y docentes? Se han cumplido las expectativas (por qué, por qué no)?

- ¿Para qué (propósitos) y cómo (procesos) se ha utilizado la información?

- ¿De qué depende el hecho que la información sea utilizada?

- ¿Qué consecuencias de corto plazo ha tenido la entrega de esta información en el establecimiento (positivas, negativas)?

- ¿Cómo se relaciona la información SEPA con otros tipos de información sobre el aprendizaje de los alumnos (p.ej., SIMCE; evaluaciones del profesor en la sala de clase)?

- ¿Cómo mejorar la claridad de la entrega de la información? ¿Qué tipo de información todavía les falta?

De modo de focalizar mejor el presente artículo, solo se presentarán en mayor detalle los resultados de las preguntas relacionadas con el uso de la información. Los resultados relacionados a la comprensión se encuentran en forma resumida en este paper, y en mayor detalle en Hein y Taut (2009).

4. Metodología

4.1. Muestra

En el año 2008 se encontraban afiliados N=101 establecimientos a SEPA, con una total de cerca de N=25.000 alumnos tomando pruebas SEPA. N=34 de los establecimientos participantes (cubriendo algo más de N=5.000 alumnos) han participado por segundo año consecutivo, por lo que recibieron la información completa sobre estado, progreso y valor agregado. De estos 34 establecimientos, 9 son de dependencia municipal (Mun.), 12 de dependencia particular subvencionada (PS) y 13 de dependencia particular pagada (PP){1}. Dentro del universo así definido, se desarrolló un screening contactando directamente a 21 establecimientos de la Región Metropolitana, para identificar establecimientos con altos niveles de uso instrumental (medidas o decisiones concretas) y establecimientos de bajo uso (ninguna medida o medidas poco concretas) de la información SEPA. Se buscó seleccionar en cada dependencia (municipal, particular subvencionado, particular pagado), dos casos de alto uso (A) y un caso de bajo uso (B).

La siguiente tabla muestra los detalles respecto a los N=7 establecimientos que finalmente se seleccionaron para el estudio.

Figura 1. Distribución de entrevistas según cargo, establecimiento,

nivel de uso y sostenedor/asesor que contrata el servicio

Cargo |

Colegio |

Dependencia |

Uso |

Sostenedor/asesor |

Director |

EC |

Mun |

A |

Em. |

Profesor matemáticas |

EC |

Mun |

A |

Em |

Director |

G |

PP |

A |

Particular |

Profesor matemáticas |

G |

PP |

A |

Particular |

Director |

RM |

PP |

A |

Particular |

Profesor matemáticas |

RM |

PP |

A |

Particular |

Profesor lenguaje |

RM |

PP |

A |

Particular |

Coordinador académico |

SM |

PP |

A |

EUC. |

Profesor lenguaje |

SM |

PP |

A |

EUC. |

Coordinador académico |

SE |

PS |

B |

EUC. |

Profesor lenguaje |

SE |

PS |

B |

EUC. |

Profesor matemáticas |

EB |

PS |

B |

EUC. |

Coordinador académico |

EB |

PS |

B |

EUC. |

Coordinador académico |

IOM |

PS |

B |

EUC. |

En cada uno de los establecimientos seleccionados se entrevistaron al menos a dos personas (un directivo y un profesor de matemática o lenguaje con un curso evaluado) por cada establecimiento, 14 entrevistas en total. La saturación conceptual se alcanzó para cada establecimiento con dos entrevistas, y para los temas del estudio general se alcanzó con las 14 entrevistas.

Las limitaciones de la muestra alcanzada son los siguientes: (a) Por dificultades de acceso a establecimientos municipales (acceso restringido por la fundación asesora, la cual contrata el servicio de SEPA) solo se pudo incluir a N=1 establecimiento municipal en la muestra final; (b) La distribución entre dependencia y el nivel de uso en la muestra final no se encuentra adecuadamente equilibrada. Esto es, N=3 establecimientos particulares pagados muestran altos niveles de uso versus N=3 establecimientos particulares subvencionados con bajos niveles de uso.

Es importante hacer notar que en N=5 de estos establecimientos el servicio SEPA era contratado por un sostenedor o asesor externo (fundaciones) al establecimiento, quien daba uso adicional a los datos para perseguir sus objetivos respecto de los establecimientos evaluados.

4.2. Recolección y análisis de datos

Se levantó información a través de la técnica de una entrevista semi-estructurada. Esta tuvo un carácter “interventivo”, ya que exploró primero reacciones y conocimientos iniciales ante un tema, luego entregó información, y finalmente exploró las reacciones ante la información entregada. Además de las entrevistas, se tomaron notas reflexivas y se elaboraron “mini-ethnografías” sobre las visitas en cada uno de los siete establecimientos en la muestra.

Las entrevistas se orientaron a través de una pauta que buscaba explorar los siguientes temas principales: 1) la caracterización del establecimiento (estrategias previas de promoción de progreso del aprendizaje), 2) los modos de uso de la información SEPA (incluyendo obstaculizadores y facilitadores), y 3) la comprensión de indicadores específicos entregados por SEPA (en base de materiales con resultados seleccionados y reales de cada establecimiento visitado).

Los datos son analizados basados en la metodología de la “Grounded Theory” (Glaser y Strauss, 1999). La utilización de este tipo de técnicas estuvo orientada a recabar información sobre las percepciones que los entrevistados tienen sobre el uso de SEPA en sus respectivos establecimientos. También se elaboró un modelo teórico que explica el fenómeno del alto o bajo uso, desde la propia perspectiva de los entrevistados, que es justamente el propósito de las técnicas planteadas por la Grounded Theory. Se aplicaron los tres tipos de codificación propuestas por ella (abierta, axial, selectiva). Para tales efectos se codificaron las respuestas de los entrevistados y se fue construyendo un sistema de categorías a través de un software especializado en análisis cualitativo (ATLAS.ti, versión 5.2). Una vez que la información fue codificada, se pudo graficar las relaciones encontradas entre las categorías.

4.3. Limitación de generalización

Es necesario explicitar que los hallazgos y conclusiones de este estudio se limitan a los establecimientos SEPA y no son extrapolables a todos los establecimientos educacionales de Chile.

5. Resultados

5.1. Resumen de resultados sobre comprensión de la información SEPA

En términos generales, es posible observar que la comprensión de los conceptos y de la información proporcionada suele ser parcial, particularmente en cuanto a los conceptos más novedosos y complejos. Los datos que con mayor facilidad se comprenden son los de estado o estatus, particularmente en el caso de las estadísticas expresadas en porcentajes de logro. Los usuarios están familiarizados con la expresión de rendimiento en porcentajes, por lo que los consideran fáciles de leer y concretos en cuanto a su interpretación. En cambio, la “escala vertical” suele no ser comprendida y, consecuentemente, tampoco los son los puntajes estandarizados para los cuales no se cuenta con herramientas de interpretación. Pese a ello, los entrevistados no consideran los porcentajes de logro son suficientes para tomar decisiones. Los indicadores de progreso muestran mayor dificultad inicial para ser comprendidos. Bastó una breve explicación orientada a proporcionar una norma de interpretación para nterpretar los datos.. Una vez comprendidos, se los percibe como útiles para lograr monitorear el progreso del establecimiento, los cursos y los alumnos.

Finalmente, en cuanto al índice de valor agregado, la mayor parte de los entrevistados entiende de su existencia, les parece inicialmente interesante, pero la comprensión del concepto y su interpretación es parcial. Una vez que se ha explicado, los datos de valor agregado se vuelven particularmente atractivos para directivos. En caso que los resultados fuesen buenos, se estima que estos pudiesen ser mostrados a los padres, como parte de una estrategia para promover la confianza de estos en la gestión del establecimiento.

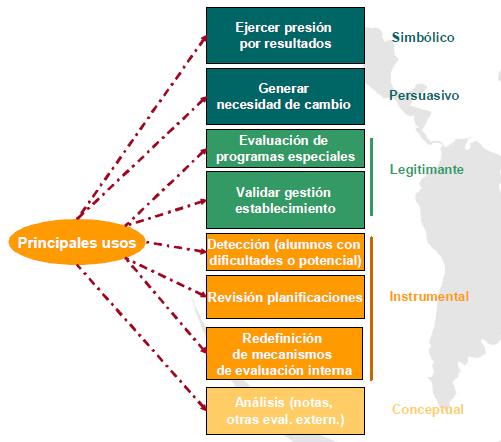

5.2. Tipos de usos observados

Un primer uso observado, y el más común de todos, tiene que ver con el uso conceptual, a saber el análisis cruzado de la información. Gran parte del contacto con la información se da en el contexto del análisis que busca relacionar los resultados observados en SEPA con los resultados observados en las evaluaciones sumativas internas, otras evaluaciones externas (SIMCE, otras) y la experiencia de docentes y directivos. Los equipos testean hipótesis, ensayando explicaciones para comprender las variaciones observadas. En esta etapa, se pone a prueba el sistema, en términos que si los resultados son coherentes con lo esperado, se convierte en una importante fuente de legitimidad del instrumento. En general, todos entrevistados coinciden en que los resultados observados han sido coherentes con la experiencia, y cuando no ha sido así, estas discrepancias pudieron ser explicadas satisfactoriamente.

La segunda medida más utilizada, tiene que ver con un tipo de uso instrumental, a saber la revisión de planificaciones del establecimiento, nivel, curso o algún alumno particular. En la medida en que el sistema ha ganado credibilidad a través del análisis cruzado de la información, los actores toman decisiones al respecto. Lo más común es que se repitan o enfaticen determinadas materias dedicándoles un mayor número de horas, o se convoque a talleres de reforzamiento a grupos de alumnos particulares.

Un tercer uso observado (instrumental), donde la revisión cruzada arroja discrepancias con la impresión de los actores y de las evaluaciones sumativas internas, es la revisión y mejoramiento de los mecanismos de evaluación interna. En dos establecimientos fue necesario desarrollar capacitaciones en construcción de instrumentos de evaluación a los docentes para instalar la capacidad de construir instrumentos de evaluación educacional y utilizarlos con fines formativos. Anecdóticamente, en un establecimiento esto trae como consecuencia el descenso general del promedio de notas de los alumnos. En ninguno de los casos mencionados estos cambios fueron desarrollados espontáneamente. En ambos casos se requirió de apoyo o presión externa (según el caso) que obligara a los equipos a aceptar las problemáticas detectadas y comprometerse con el cambio requerido.

Una cuarta forma de uso (instrumental), tiene que ver con la detección de alumnos con dificultades o con talentos. En realidad más que detectar alumnos con dificultades particulares, en opinión de los entrevistados la información SEPA permite confirmar que alumnos que suelen tener mal rendimiento académico también obtienen pobres resultados en las pruebas SEPA. Dado que existe una relación relevante entre los resultados y lo que los profesores suelen esperar de sus alumnos, el aporte más relevante que hace el SEPA en este aspecto, tiene que ver con la detección de alumnos que tienen rendimientos discrepantes con lo esperado. Particularmente en un establecimiento también se logró detectar un talento insospechado a través de las pruebas SEPA. En este último caso se opta por potenciar las habilidades del alumno con asignaciones especiales en matemáticas. Como resultado final el alumno, previamente de rendimiento mediocre mejora su desempeño en todas las asignaturas.

Una quinta forma de uso, de tipo legitimante, se observa en equipos directivos y tiene que ver con la validación de la gestión de la organización. Específicamente, en el caso que los resultados obtenidos son valorados como positivos, estos resultados son utilizados para demostrar, que la gestión del establecimiento ha sido la adecuada. En específico, puede ser utilizada, ya sea para presentar los resultados ante los padres, o simplemente como forma de reafirmar internamente que el desempeño ha producido el efecto deseado. Esto cobra relevancia en establecimientos que son total o parcialmente financiados por apoderados, donde y mantener la confianza de los apoderados es clave garantizar la estabilidad de la matrícula.

Una sexta forma de uso tiene que ver con la evaluación de los resultados de programas pedagógicos especiales implementados con anterioridad a la introducción de SEPA. En principio si bien esto parece un uso instrumental, el desarrollo de esta evaluación tuvo un carácter legitimante, debido a que la instalación del nuevo programa pedagógico estuvo lleno de controversias.

Un séptimo uso detectado, esta vez desde los asesores externos-clientes de SEPA, tiene que ver con la utilización de los resultados generados para motivar a los equipos directivos y docentes para generar la necesidad de un cambio (uso persuasivo). Las organizaciones externas que asesoran o de las cules dependen los establecimientos, estaban particularmente interesadas en convencer a los directivos y docentes de los establecimientos, de que era necesario hacer un cambio. Más allá de estos casos, se observa una alta preocupación por el modo que se transmitirán resultados de la evaluación al cuerpo docente. Esto es así tanto en establecimientos con restricciones a la movilidad docente (establecimientos municipales) como en establecimientos que no tienen estas restricciones (particulares y particulares pagados). Se estima que si el cuerpo docente no legitima la evaluación, no se podrán implementar acciones a partir de esta. Es interesante destacar que la legitimidad que goza la institución a cargo de SEPA resulta ser un elemento que respalda a los equipos internos y externos encargados de “bajar” la información, particularmente en el caso que los resultados observados no son los esperados, momento en que se refieren mayores resistencias en los equipos docentes.

Figura 2. Tipos de usos de la información SEPA detectados en establecimientos del estudio

Finalmente un último uso observado tiene que ver con la presión por resultados (accountability) aunque en un formato inesperado. En un caso particular, se pudo observar como el director de un establecimiento era asesorado por un organismo externo cuyos honorarios eran financiados por un donante conseguido por este mismo director. Al tomar conocimiento de los índices no favorables de valor agregado, el director utilizó esta información para presionar al asesor externo y responsabilizarlo por la falta de resultados, a tres años del inicio de la consultoría. Podría decirse que es un uso de tipo simbólico, ya que si bien se refiere a los datos, tiene que ver más bien con el envío de una “señal” más que en acciones concretas (como por ejemplo lo hubiese sido despedir a la consultora).

La Figura No. 2 ofrece un resumen gráfico de los usos detectados.

5.3. Condiciones que favorecen o dificultan el uso de información evaluativa

Se pudieron hallar una serie de condiciones que pueden facilitar o dificultar el uso de la información evaluativa. En primera instancia vale la pena destacar cual es la relación que se observa entre el uso de la información SEPA y la estrategia previa que tenía la escuela para promover el progreso del aprendizaje de los alumnos. En segunda instancia se identifican factores particulares que facilitan o dificultan el uso de la información SEPA.

5.3.1. Relación entre el tipo de uso y la estrategia previa de progreso del aprendizaje del establecimiento

- Estrategia previa de promoción del progreso del aprendizaje. Frente a los desafíos que se les plantea a los establecimientos para promover el progreso del aprendizaje de sus alumnos, estos desarrollan diversas estrategias. Una “estrategia” consta de al menos tres elementos, a saber de herramientas de detección de alumnos o cursos que muestran dificultades en determinados contenidos, las estrategias de análisis/toma de decisiones de intervención y finalmente cuales son los tipos de respuestas disponibles existentes. Los establecimientos suelen tener una estrategia que varía en cuanto a su formalidad y capacidad de respuesta personalizada a las necesidades de alumnos particulares.

En cuanto a los mecanismos de detección, los establecimientos recurren principalmente al uso de evaluaciones estructuradas (sumativas o formativas internas o externas) o la detección a través de profesionales de apoyo (por ejemplo el departamento de orientación). Los establecimientos que utilizan pruebas sumativas internas o de evaluaciones externas con fines formativos, suelen tener mayores niveles de uso de la información SEPA y muestran un discurso fuertemente orientado a la tarea. Estas herramientas permiten monitorear el progreso de los estudiantes, tomar decisiones para la implementación de medidas remediales y comunicar los resultados a los apoderados y a los alumnos haciéndolos partícipes de la metas de aprendizaje del establecimiento. Los establecimientos con resultados positivos de VA, tienden a monitorear el progreso con herramientas estructuradas de evaluación.

Los resultados de estas evaluaciones son analizados por diversos actores de la organización escolar (profesores, coordinadores, consejos escolares). Se observa multiplicidad de estrategias que involucran diferencialmente a distintos actores según las características y aprehensiones propias de los equipos directivos.

Una tercera característica relevante de la estrategia tiene que ver con el repertorio de medidas remediales de las que dispone el establecimiento. Las medidas más comunes desplegadas, una vez que se ha detectado alguna discrepancia respecto del progreso esperado, son las siguientes:

- Revisión de planificaciones: Se refiere a la modificación de la planificación para alumnos que manifiestan alguna dificultad. En los establecimientos que tienen procesos más formales de evaluación formativa, se hace una revisión grupal regular de las planificaciones de cursos y niveles involucrando al profesor, al coordinador, y a otros profesores pares del nivel.

- Innovación en métodos pedagógicos:Hay ocasiones en que se siente la necesidad de desarrollar innovaciones en los métodos pedagógicos para abordar determinado tema o determinado subsector. En estos casos, los establecimientos suelen apoyar la capacitación de los docentes en técnicas determinadas para los ámbitos que se van a reforzar.

- Desarrollo de reforzamientos grupales:Otra medida común observada es el desarrollo de reforzamiento dirigido a temas y grupos particulares. El reforzamiento se implementa fuera de las jornadas habituales de clases. Esta suele ser una medida excepcional que regular y suele estar orientada a grupos mas que a alumnos específicos.

- Contrato con padres de alumnos de bajo rendimiento:Cuando los problemas de rendimiento de un alumno se vuelven relevantes se involucra a los padres. Se asegura su participación a través de “contratos” donde padres, hijos y el establecimiento se comprometen a determinadas acciones orientadas a mejorar el rendimiento del alumno.

- Inter-consulta con profesionales de apoyo: En casos de mayor complejidad, el problema suele ser “externalizado” del aula, es decir se busca apoyo externo para abordar el caso consultando profesionales internos o externos del establecimiento (psicólogo, psicopedagogo, orientador, neurólogo) si es que estos están disponibles.

Los establecimientos tienden a preferir el uso de medidas remediales con un foco grupal, opción que facilita la gestión de respuestas y responden a problemas generalizados en el establecimiento, nivel o curso. La capacidad de los establecimientos de responder a necesidades particulares de los alumnos es usualmente limitada.

Establecimientos con problemas de rendimiento, suelen no tener una estrategia articulada de progreso (particularmente de evaluación y monitoreo). Esto se observa con mayor claridad en dos establecimientos, que comparten además una orientación que enfatiza las necesidades afectivas de los alumnos por sobre sus resultados de aprendizaje.

- Uso de la información SEPA y estrategias previas de promoción de progreso del aprendizaje. La estrategia de progreso de aprendizaje con que cuenta el establecimiento previo a la introducción de SEPA parece ser determinante del nivel de uso que se le dará a la información. El tipo de respuestas que implementarán estarán dadas por el repertorio previo de respuestas posibles que tiene el establecimiento. Esto es consistente con la descripción de Nevo (2001).

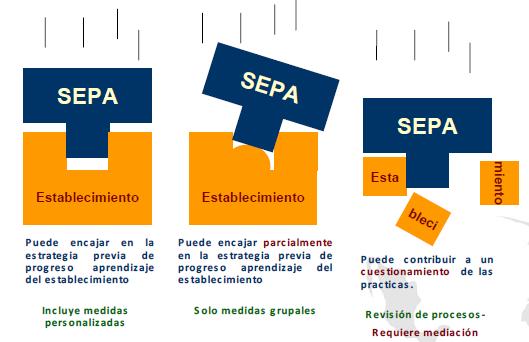

Dadas las estrategias previas del establecimiento es posible observar tres escenarios, esquematizados en la Figura Nº3.

(1) En un primer escenario, la información proporcionada por el sistema SEPA encaja en la estrategia previa, lo que facilita el uso completo de la información para la toma de decisiones. Esto es que el establecimiento tiene un repertorio de respuestas posibles que permite diseñar respuestas a nivel de establecimiento, curso y alumnos particulares. No solamente se utiliza la información a nivel de establecimiento o de curso, si no que se diseñan respuestas para alumnos particulares.

(2) En un segundo escenario, la información proporcionada por el sistema SEPA encaja parcialmente en la estrategia previa. Se cuenta con un repertorio de respuestas de orientación grupal (niveles, cursos o grupos), sin contemplar respuestas para alumnos particulares. Cuando se observan problemas de progreso en alumnos particulares, la tendencia es a externalizar la respuesta.

(3) En un tercer escenario, la información proporcionada por SEPA revela una discrepancia relevante con la percepción previa del desempeño del establecimiento, lo que obliga a que el staff revise sus procedimientos. Queda la impresión que cambios relevantes en la estrategia existente solamente son posibles con apoyo externo (mediador), especialmente si el establecimiento se ha visto cuestionado por su bajo rendimiento.

Figura 3. Relación entre el uso de SEPA y la estrategia previa del establecimiento

5.3.2. Factores específicos asociados a un alto uso de la información SEPA

En esta sección se hace una síntesis da los factores que parecen afectar el nivel de uso de la información. Estos pueden ser clasificados según su relación con condiciones previas del establecimiento, o con características propias de SEPA. La síntesis de estos factores se desarrolla en la figura Nº4.

Entre las condiciones previas del establecimiento asociadas a un alto uso de la información SEPA, se cuentan:

- Un alto nivel de motivación de los docentes: Factor asociado al compromiso y voluntad de los docentes de implementar cambios, particularmente en el nivel de la gestión del trabajo de aula.

- Un alto nivel de confianza entre directivos y docentes: Este factor facilita la bajada de la información, la comunicación y discusión de medidas remediales. Un alto grado de confianza no implica que la información se maneje abiertamente, y el manejo abierto de la información tampoco está necesariamente asociada a un alto uso. Por ejemplo en un establecimiento se observa alto uso (en docentes y directivos) pese a que la información se da a conocer solo parcialmente por temor a un posible mal uso.

- El interés del director o sostenedor: Este resulta fundamental para introducir la necesidad de cambio en la organización. El director/sostenedor define la agenda, determina las prioridades y establece los énfasis con que se abordarán determinados temas, incluyendo la evaluación formativa. Si, el interesado (director/sostenedor) debe tener el poder para tomar decisiones y definir consecuencias por incumplimiento.

- Existen consecuencias asociadas: Este se refiere a que la información se utiliza para tomar decisiones concretas. Si esto no se da, el análisis de la información se convierte en un ejercicio irrelevante para la práctica docente dando lugar a una situación de bajo uso de la información.

- El uso de la evaluación formativa ya se encuentra instalado: Si ya existe el hábito de utilizar herramientas de evaluación formativa, la introducción de SEPA resulta mucho más fácil. Si SEPA compite con otro sistema de evaluación interna, se usa el que tenga consecuencias asociadas.

- Se dispone de equipos competentes y con tiempo para analizar la información: La disponibilidad de equipos profesionales con capacidad de interpretación de datos numéricos, competencias informáticas adecuadas (manejo web y planilla de cálculo), y tiempo suficiente para desarrollarlo, resulta ser un elemento que facilita la decodificación de la información entregada a través de la web.

- Como ya se mencionaba anteriormente, la disponibilidad de mediación interna o externa que acompañe a los equipos en el procesamiento de la información, parece ser un facilitador asociado a un posterior uso de la información. El que actúa como mediador no solamente debe poder comprender los datos, sino que dominar un rango de habilidades blandas que le permitan manejar y confrontar las resistencias emergentes en el proceso.

- Como también se describió anteriormente en detalle, la forma en que se organiza previamente la estrategia de progreso del aprendizaje del establecimiento, puede facilitar o restringir la aplicación de la información proporcionada. Establecimientos que solamente contemplan un repertorio de respuestas centradas en los grupos, aprovechan menos la información proporcionada.

- Finalmente, en cuanto a la orientación filosófica de la escuela, esta facilita el uso, en la medida que centre su atención en el progreso del aprendizaje. Establecimientos centrados solamente en acoger a los alumnos suelen presentar mayores dificultades de rendimiento. Esto puede estar asociado también con el hecho que estos establecimientos reciben a alumnos con historias de vida mas desfavorecidas. Otros establecimientos equilibran ambas orientaciones.

En cuanto a las características asociadas a SEPA se pueden identificar las siguientes:

- Comprensión de la información: Se pudo observar que el uso de la información se facilita en la medida que al menos un representante del establecimiento comprende adecuadamente la información proporcionada. Esta variable parece ser crítica. Se constata que la mayor parte de los actores (incluso los alto uso), comprenden solo parcialmente la información proporcionada los conceptos introducidos. Los actores enfrentan diversas dificultades para dar sentido a la información (procesarla y relacionarla con hechos, procedimientos, conceptos, interpretaciones, ideas, observaciones y juicios propios). Solamente una vez que la información ha sido procesada, es que es posible que sea utilizada (Alavi & Leidner, 2001). La novedad de la herramienta, la falta de tiempo, la forma de organización de los contenidos de la página web (supone que las personas exploran la web en forma secuencial: leer primero la sección definiciones, luego los datos, luego los anexos) y la falta de competencias de análisis dificultan la comprensión. En cambio, el contar con asesoría externa (o equipo interno competente) facilita la comprensión y de este modo el uso.

- Percepción de utilidad de la información: Se observan usos diferenciados en los actores según las necesidades. Profesores estiman que la información más útil es aquella que desglosa el rendimiento por alumno y /o por subsector. Pese a ello, la especificidad con que SEPA describe los sub-ejes no les parece suficiente para tomar decisiones pedagógicas. En cambio la corrección de preguntas de respuesta abierta se percibe como muy útil, porque permite derivar fácilmente acciones remediales. Por otra parte la información sobre el establecimiento o sobre el valor agregado, es más valorado por directivos que por docentes

- Entrega oportuna de la información: Como distintos tipos de resultados son entregados en dos fechas distintas (diciembre y marzo), aquellos entregados en el segundo momento (“progreso”) son menos utilizados. En parte esto se debe a que ya se han analizado los resultados de “estado” y se han tomado decisiones, pero por otra parte se debe a que la planificación del año suele cerrarse en febrero. Si los resultados llegan en marzo es difícil que sean considerados.

- Acceso web y diseño de la plataforma de entrega de información: Algunos elementos asociados al acceso de la web como la estructura de la organización de la información pueden llegar a dificultar el acceso y comprensión de los datos. Se observan inconvenientes específicos con la calidad con que se puede imprimir la información (por ejemplo tablas cortadas), y con la exportación de archivos, funcionalidad que no todos los actores conocen. Aun en establecimientos de alto uso, se observan dificultades asociadas al manejo de herramientas informáticas. Si bien el acceso web es valorado, algunos actores preferirían tener la opción de acceder a un informe escrito.

- Legitimidad: La legitimidad que tiene SEPA para los destinatarios de la información, es un elemento muy relevante para su uso. Si la herramienta no es creíble, esta no es utilizada. Las fuentes de legitimidad, son la congruencia de los resultados de SEPA con otros instrumentos o experiencia, el orden de la presentación de los datos, el orden con que se desarrolla el proceso de levantamiento de los datos y el prestigio de la institución que desarrolla el sistema. Si hay dudas en alguno de los niveles anteriores, el prestigio de la universidad contribuye a dotar de legitimidad de la herramienta. Esto es un elemento particularmente valorado en el caso que se requiera convencer a los equipos sobre la necesidad de un cambio.

- Un último elemento tiene que ver con el hecho que los resultados sean interpretados como positivos. Si esto es así, su uso se facilita. Resultados percibidos como negativos son sometidos a un mayor escrutinio orientado a desacreditar la herramienta de modo de no tener que enfrentar a necesidad de revisar sus procesos.

Figura 4. Síntesis de factores asociados a un alto uso de la información SEPA

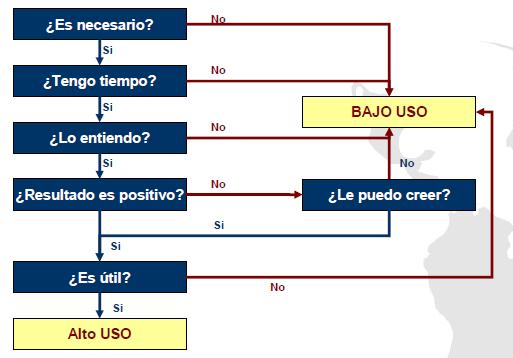

5.3.3. Resumen: Como los usuarios determinan si utilizan o no la información SEPA

Figura 5. Preguntas críticas que se formulan docentes al enfrentarse a la información SEPA

Pareciera ser que existe una secuencia de preguntas internas que los usuarios finales se hacen al momento de confrontarse con información evaluativa de SEPA. Uno de los elementos más relevantes tiene que ver la necesidad de uso, usualmente mandatada por el director o el sostenedor. Como se mencionó anteriormente, el mandante debe ser una figura con poder para definir consecuencias. Esto se pudo observar en establecimientos donde convivían dos sistemas de evaluación. Aquel sistema de evaluación que tenía consecuencias para el sostenedor, era el sistema mas utilizado. En una segunda instancia entran en juego las condiciones efectivas de tiempo y acceso a la información para poder procesar la información. Luego entran en juego factores de comprensión de los datos. En este momento la mediación se vuelve crucial. Finalmente, se evalúa si los resultados son amenazantes, y si lo son, si estos son creíbles. Solamente en una última instancia se evalúa la aplicabilidad y utilidad de los datos (desagregación, calidad de la descripción de las categorías, etc.). En la figura Nº5 se resumen las preguntas internas en formato de flujograma.

6. Conclusiones

Tal como se anticipó, si bien se han tomado diversos resguardos para que el sistema sea lo menos amenazante posible y efectivamente brinde información útil para los actores escolares, la relación que los actores establecen con la información evaluativa es altamente compleja y depende de las características de la organización y del sistema educativo.

Tal como se puede apreciar en la literatura, los usos que se le pueden dar la información evaluativa son múltiples, y solamente una fracción de estos tiene que ver con un uso instrumental directo. Pese a ello, la mayor parte de los usos observados tienen una relación directa o indirecta con la meta de mejorar las prácticas pedagógicas del establecimiento. La multiplicidad de usos pone de manifiesto que la introducción de información es solamente una parte del proceso necesario para influir el cambio necesario en las organizaciones escolares.

En este contexto resalta la relevancia de las características de la organización escolar y sus particularidades como centrales para comprender cuales serán las respuestas probables a la introducción de un sistema como SEPA. Tal como fue posible anticipar a través de la revisión bibliográfica, existen características fundamentales de la organización que tienen un alto peso al momento de definir como se responderá al input de información evolutiva. Dentro de estas, se encuentran el repertorio previo de respuestas anclado en la estrategia pedagógica previa de la organización (Shula y Cousins, 1997), la capacidad de los equipos internos en general y específicamente de comprender e interpretar la información presentada (Earl y Fullan, 2003; Elmore 2008), la instalación previa de sistemas internos de evaluación (Nevo, 2001) asociados a la presencia de una cultura de la evaluación (OCDE, 2005; Scheerens, 2004).

Por estas razones, y dado que la introducción de información evaluativa a una organización nunca es un ejercicio neutro (aunque una organización particular haya accedido voluntariamente a someterse a esta evaluación), es que este proceso debiese considerar cuales son las características de la organización escolar que recibirá la información. Organizaciones que adhieren voluntariamente al programa (o cuentan con un mandante con poder efectivo), que cuentan con equipos competentes en análisis de datos y habilidades blandas para comunicar y manejar resistencias, que cuentan con sistemas o al menos practicas evaluativas internas, que cuentan con una cultura de la evaluación que se desarrolla en un marco de confianza, estarán en una mejor posición para aprovechar la información evaluativa desarrollada por SEPA.

En cambio, organizaciones que no cuenten con alguna de estas características, posiblemente pueden requerir apoyo externo para desarrollar cambios tendientes a mejorar el desempeño organizacional. Se observa que una estrategia que parece tener resultados tiene que ver con el apoyo de una organización externa que pueda suplir capacidades organizacionales importantes tales como la capacidad de análisis o de capacidad de autocrítica observada en organizaciones con culturas de evaluación instaladas. En otras palabras, en este tipo de organizaciones se requiere que la información pueda ser mediada por actores competentes externos que permitan decodificar, interpretar, contener las ansiedades y apoyar el desarrollo de capacidades internas de trabajo.

En este sentido, es posible coincidir con Elmore (2008), en que la construcción de capacidad de responder ante sistemas de evaluación externa como SEPA es un problema fundamental asociado a su introducción y aprovechamiento. En este sentido, el sistema SEPA funciona sobre la base del supuesto, que los establecimientos educacionales harán un uso instrumental de los datos, sin considerar sus capacidades instaladas, suposición que no se confirma. Si el objetivo del sistema es contribuir al mejoramiento de la calidad de los procesos de enseñanza aprendizaje, entonces el sistema debiese considerar la incorporación de medidas que permitan facilitar este proceso.

Este proceso podría apoyarse de diversas maneras, tales como ofrecer asesoría individualizada, brindar cursos temáticamente focalizados o generar una plataforma de intercambio de experiencias entre actores y organizaciones miembros de SEPA. De este modo se podría desarrollar una plataforma de servicios agregados que, no solamente confronten al establecimiento con un estándar de desempeño, si no que además permita acceder a herramientas para cerrar las brechas detectadas. Esta plataforma de servicios se puede desarrollar además en función del tipo de capacidad que un establecimiento debe desarrollar en orden de aprovechar la entrega de información evaluativa externa. En el futuro, sistemas similares debiesen considerar, desde el inicio, el problema de la facilitación del proceso de uso de la información evaluativa como parte del paquete de servicios ofrecidos.

Referencias Bibliográficas

Alavi, M. & Leidner, D.E., (2001) : Review: knowledge management and knowledge management systems: Conceptual foundations and research issues. MIS Quarterly 25 (1), 105–136.

Alkin, M., & Taut, S. (2003). Unbundling evaluation use. Studies in Educational Evaluation. (29), 1-12. Black, P. & Wiliam, D. (1998): Inside the black box: Raising standards through classroom assessment. Phi delta Kappan, October, 139 - 148

Earl, L. & Fullan, M (2003). Using data in leadership for learning. Cambridge Journal of Education33 (3), November, 383 - 394

Elmore, R. (2008). School reform from the inside out: Policy, practice and performance. Harvard Education Press, Cambridge M.A. Canada.

Fullan, M, (2002). Principals as leaders in a culture of change. Educational Leadership, Special Issue. May

Fullan, M, (2006). Change theory: A force for school improvement. Seminar Series Paper Nº. 157, November. Centre for Strategic Education. Jolimont, Australia.

Funderburg, S. A. & Levy, P. E. (1997). The influence of individual and contextual variables on 360-degree feedback system attitudes. Group & Organization Management, 22 (2), pp.210-35.

Gareis, C. (2007). Reclaiming an important teacher competency: The lost art of formative assessment. Journal of Personnel Evaluation in Education, 20, 17–20.

Glaser, B. & Strauss, A. (1999). The discovery of grounded theory: Strategies for qualitative research. Sociology Press.

Hein, A. & Taut, S. (2009). Informe de un estudio de comprensión y uso de la información SEPA. Documento interno MIDE UC, Pontificia Unversidad Católica de Chile, Santiago, Chile.Joint Committee on Standards for

Educational Evaluation (1994). The program evaluation standards. Thousand Oaks, CA: Sage.

Koretz, D. (2008). Measuring Up: What educational testing really tells us. Cambridge, MA: Harvard University

Press.Looney, J. (2007). Formative assessment in adult language, literacy and numeracy. Assessment in Education: Principles, Policy & Practice,14 (3), 373 — 386.

McDowell, L. Smailes, J., Sambell, K., Sambell, A. & Wakelin, D. (2008). Evaluating assessment strategies through collaborative evidence-based practice: Can one tool fit all? Innovations in Education and Teaching International 45 (2), May, 143–153.

Milanowski, A.T. & Heneman III, H.G. (2001). Assessment of teacher reactions to a standards-based teacher evaluation system: A Pilot Study. Journal of Personnel Evaluation in Education, 15(3), 193-212.

Navarro, J. C. (2003). La evaluación y las actitudes de los docentes frente a ella: Dificultades y alternativas de política. En Evaluar las evaluaciones: Una mirada política acerca de las evaluaciones de la calidad educativa. Buenos Aires: IIPE-UNESCO, pp. 147-164

Nevo, D. (2001). School evaluation: Internal or external?. Studies in Educational Evaluation, 27 (2),95-106.

OCDE (2005): Formative assessment: improving learning in secondary classrooms. Paris, Francia. Disponible en línea http://www.oecd.org/document/39/0,3343,en_2649_35845581_34365415_1_1_1_1,00.html

OCDE (2008): Measuring Improvements in learning outcomes. Best practices to assess the value added of schools. Paris, France. Disponible en línea http://www.oecd.org/document/54/0,3343,en_2649_39263231_41701046_1_1_1_1,00.html

Owen, J.M. & Rogers, P. (1999): Program evaluation: forms and approaches (2 Ed.). London: Sage.

Patton, M.Q. (2008): Utilization-focused evaluation. Fourth Edition SAGE Publications, Inc., California.

Rich, R.F. (1977). Uses of social science information by federal bureaucrats: Knowledge for action versus knowledge for understanding. In C.H. Weiss (Ed.), Uses of social research in public policy pp. 199– 211. Lexington, MA: D.C.

Ruiz-Primo, M. & Furtak, E. (2007): Exploring teachers’ informal formative assessment practices and students’ understanding in the context of scientific inquiry. Journal of Research in Science Teaching, 44, (1), 57–84

Santelices, V. & Taut, S. (2009). Comprehension and use of value-added school indicators by parents and teachers. Paper presented at the Annual Conference of the European Educational Research Association, September 28-30, 2009, Vienna, Austria.

Scheerens, J. (2004). The evaluation culture. Studies in Educational Evaluation, 30, 105-124.

Scriven, M. (1967): The methodology of evaluation. In R. Tyler, R. Gagne, and M. Scriven (Eds.), Perspectives of curriculum evaluation (pp. 39-83). Chicago: Rand McNally.

Shula, L.M., & Cousins, J.B. (1997): Evaluation use: theory, research, and practice since 1986. Evaluation Practice, 18 (3), 185-208.

Taut, S. & Alkin, M. (2003): Program staff perceptions of barriers to evaluation implementation. American Journal of Evaluation, 24, (2), 213-226.

Taut, S. & Brauns, D. (2003). Resistance to evaluation: A psychological perspective. Evaluation, 9, (3), 247-264.

Taut, S., Cortés, F., Sebastian, C. & Preiss, D. (2009). Evaluating school and parent reports of the national student achievement testing system (SIMCE) in Chile: Access, comprehension, and use Evaluation and Program Planning. 32, 129–137

Weiss, C. (1998). Have we learned anything new about the use of evaluation? American Journal of Evaluation 19(1), 21-33.

Wiliam, D. & Black, P. (1996). Meanings and consequences: A basis for distinguishing formative and summative functions of assessment? British Educational Research Journal, 22, (5), 537-548.

Wiliam, D., Lee, C., Harrison, C., & Black, P. J. (2004). Teachers developing assessment for learning: Impact on student achievement. Assessment in Education, 11, 49–65.

Wildawsky, A. (1972). The self-evaluating organization. Public Administration Review, 32(5), 509-520.

{1} Los establecimientos de dependencia municipal son establecimientos públicos administrados por cada gobierno local. Los establecimientos de dependencia particular subvencionada son establecimientos pagados con subvención estatal y los establecimientos de dependencia particular pagada son establecimientos privados y pagados.