As Instituições Federais de Ensino Superior (IFES), inseridas num ambiente turbulento e impelidas pelas novas contingências sociais, tecnológicas, políticas e econômicas, vêm, cada vez mais pressionadas a prestar contas à sociedade e aos órgãos reguladores da educação no País sobre os impactos e resultados de suas ações, especialmente daquelas levadas a cabo com verbas públicas. Formuladores de políticas, mídia, pais de alunos e os próprios alunos estarão cada vez mais atentos aos resultados das ações tradicionais das instituições. Espera-se, portanto, que as universidades tenham desempenhos consequentes em suas atividades fim, capazes de garantir um bom padrão de qualidade de seus serviços à sociedade.

Os gestores assumem importante papel, o qual exige fortemente uma tomada de decisão sobre as atividades que levem ao sucesso, reconhecendo o contexto organizacional da instituição com maior frequência e em menor tempo. Essa decisão necessita ser tomada com base na análise de informações precisas, confiáveis e completas, uma vez que o valor da decisão é diretamente proporcional à qualidade das informações utilizadas. Não é possível entender e estudar as tendências da educação superior, sem conhecer a realidade atual e para isso, torna-se essencial as informações resultantes das práticas de avaliação.

A avaliação passou a ser um instrumento de controle privilegiado do Governo e de órgãos financiadores. Tendo em vista a eficiência que cada uma é capaz de demonstrar, a avaliação se torna um guia, especialmente, na política da distribuição de recursos e no controle de credenciamento e recredenciamento.

Existe, atualmente, no País, a crescente consciência sobre a necessidade de desenvolver sistemas que avaliem as instituições. Mediante uma sistemática permanente de avaliação, a instituição identifica seus pontos fortes e fracos e assim promove a melhoria da qualidade de seus serviços, a orientação de seu quadro de pessoal, o aumento permanente da sua eficácia institucional, e, principalmente, dos seus compromissos sociais.

A administração da Universidade precisa, então, utilizar da melhor forma possível os recursos disponíveis, procurando antecipar a evolução de uma organização diante das mudanças do ambiente em que ela está vivendo, para tirar melhor proveito das oportunidades e minimizar os efeitos adversos das ameaças.

Estabelecer uma relação entre as atividades acadêmicas e a eficiência que cada uma delas é capaz de demonstrar na sua implementação torna-se um elemento essencial para dar apoio a gestão da instituição. Cabe-lhe, portanto, a análise da eficiência acadêmica e, para isso, é requerida a aplicação de métodos formais de avaliação de eficiência. Considerando essa perspectiva, temos como principal objetivo neste trabalho realizar um estudo descritivo sobre o desempenho dos cursos de graduação da Universidade Federal do Ceará (UFC), durante o período 2006 a 2009, mediante uso de um método formal de avaliação de eficiência.

1. A UTILIZAÇÃO DE INDICADORES COMO COMPROMISSO COM A QUALIDADE DA GESTÃO ACADÊMICA

Indicadores são medidas, ou seja, são números atribuídos a objetos, acontecimentos ou situações, de acordo com certas regras. Como medidas, os indicadores referem-se às informações que, em termos conceituais, são mensuráveis, independentemente de sua coleta obedecer a técnicas ou abordagens qualitativas ou quantitativas. Existem diferentes conceitos de indicadores, expressando perspectivas sutilmente diferenciadas. A Organização de Cooperação e Desenvolvimento Econômico (OCDE) define indicadores como sendo.

[...] parâmetro, ou valor calculado a partir de parâmetros, fornecendo indicações sobre ou descrevendo o estado de um fenômeno, do meio ambiente ou de uma zona geográfica, de uma amplitude superior às informações diretamente ligadas ao valor de um parâmetro. (2002, pp. 191).

Acrescenta ainda que “[...] devem, com a devida frequência, ser completados com outras informações qualitativas e científicas, sobretudo para explicar fatores que se encontram na origem de modificações do valor de um determinado indicador” (OCDE, 2002, pp. 191).

No âmbito da gestão organizacional, Kaplan e Norton (2000) defendem a ideia de que a utilização de indicadores traz a possibilidade de averiguar a implantação e o gerenciamento da estratégia, contribuindo para melhorar a performance de uma unidade de negócio ou de toda a instituição, formando, assim, instituições sustentáveis. Os indicadores proporcionam a revelação de aspectos significativos para a melhoria contínua do processo acadêmica, fornecendo informações relevantes sobre a realidade. Os administradores públicos, os diretores e os políticos mostram-se interessados por um instrumento que lhes permita destacar, de modo sintético, o mais relevante de seu campo de atuação e oriente-os, assim, na tomada de decisões (UFC, 2006).

A OCDE classifica os indicadores em quatro diferentes grupos (UFC, 2007):

- indicadores de contexto – explicam-nos os resultados institucionais obtidos, mediante apresentação das condições de demanda e das características demográficas, socio-econômicas e culturais da população discente atendida;

- indicadores de recursos – informam-nos dos recursos materiais e humanos disponíveis no contexto institucional;

- indicadores de processos – dão-nos informações acerca da influência exercida sobre a implementação de ações de diversas naturezas;

- indicadores de produtos – permitem-nos obter informações acerca dos logros institucionais no âmbito do ensino, da investigação e da extensão.

Andriola (2004) destaca que, no campo educacional, a seleção de um conjunto de indicadores, embora limitado, mas significativo, torna-se um recurso que proporciona disponibilizar informações valiosas sobre aspectos relevantes da realidade, permitindo assim, apresentar uma ideia sumária do funcionamento de uma dada realidade. Constata-se, ainda, que instituição de ensino superior se transformou numa organização administrada, que precisa cumprir metas e alcançar indicadores de desempenho capazes de responder às expectativas da sociedade, e da pessoa.

Somente a avaliação associada à pesquisa irá conseguir identificar a relação causa e efeito e, assim, desvendar a realidade sobre a qualidade universitária. Para Balzan (2008, pp. 116), avaliação e qualidade não se separam, “há necessidade de se avaliar para se desenvolver a qualidade e há necessidade de se avaliar e inovar a própria avaliação”. Na perspectiva de Firme (1994), a avaliação é parceira da pesquisa: enquanto a pesquisa procura, fundamentalmente, estabelecer relações entre fatos, fenômenos, situações, a avaliação se preocupa com o aperfeiçoamento. A avaliação visa a conclusões que levam a uma ação, a um aperfeiçoamento, porque envolve essencialmente um juízo de valor. Portanto, a pesquisa descobre o mundo e a avaliação melhora o mundo (FIRME, 1997).

Scriven (1991) conceitua qualidade em educação delimitando-a em dois atributos: valor e mérito. O valor é exibido quando o objeto educacional utiliza os seus recursos de forma a atender às necessidades dos stakeholders (interessados e impactados); e exibe mérito quando faz bem o que se propõe fazer. Assim, um objeto educacional pode ter mérito e não ter valor, se ele não atende às necessidades dos seus stakeholders; porém, todo objeto que não tenha mérito não tem valor, pois, se ele não faz bem o que se propõe fazer, não pode estar empregando bem os seus recursos para atender às necessidades de seus stakeholders.

Avaliar o desempenho acadêmico é verificar, por intermédio de técnicas e atividades operacionais, quantos requisitos previamente estabelecidos são atendidos. Tais requisitos são a expressão das necessidades, explicitados em termos quantitativos ou qualitativos, e têm por objetivo definir as características de um processo educacional, a fim de permitir o exame de seu atendimento às necessidades do usuário.

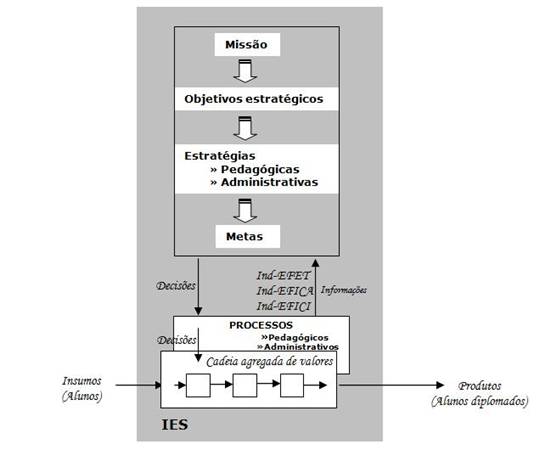

A Figura 1 apresenta um modelo de indicadores de desempenho aplicado à atividade de ensino, considerada como estratégica para uma instituição do ensino superior, uma vez que suas atividades fim estão voltadas para a formação de alunos. Os indicadores Ind-EFET (Indicador de Efetividade), Ind_EFICI (Indicador de Eficiência) e Ind_EFICA (Indicador de Eficácia), refletem a relação entre produtos (outputs) e insumos (inputs).

Figura 1. Visão geral do modelo de indicadores da IES

Fonte: Adaptado de TACHAZAWA; ANDRADE (2006)

Esse modelo de avaliação do desempenho de Instituições de Ensino Superior (IES) considera o indicador de efetividade (Ind_EFET) como a capacidade da administração da instituição em responder às necessidades ou provocar mudanças reais no público-alvo, fundamentando-se na Teoria dos Sistemas Abertos. Essas mudanças reais podem ser atingidas sob diferentes perspectivas ou critérios, dentre eles, o grau de alcance da formação acadêmica conforme programação preestabelecida.

O indicador de eficácia (Ind_EFICA) como sendo o grau em que a instituição atinge os objetivos e as metas de uma ação orientada para um alvo particular, em um determinado período, independentemente dos custos nos quais se incorra. Dessa forma, mostra o nível de alcance dos objetivos, visando a responder ao questionamento se as unidades/subunidades acadêmicas produzem resultados que atendam às metas educacionais estabelecidas pela instituição. Para Hall (2006), eficácia é definida como a capacidade que a organização detém para atingir os seus objetivos, mais explicitamente, “fazer o que deve ser feito, isto é, cumprir o objetivo determinado”.

O indicador de Eficiência (Ind_EFICI) aponta a habilidade da administração da instituição de transformar em resultados os recursos disponíveis, otimizando a relação custo-benefício. Esse critério é econômico e revela a capacidade administrativa de produzir o máximo de resultados com o mínimo de recursos, energia e tempo. Representa, portanto, uma medida segundo a qual os recursos são convertidos em resultados de modo mais econômico.

As instituições federais de ensino superior, no entanto, têm características que fazem com que seja difícil medir a eficiência. Caracteriza-se como instituição sem fins lucrativos, apresentando dificuldade de apropriação de custos (administrativos, equipamentos, materiais) e de medição do tempo efetivamente gasto nas atividades de produção, além de produzir múltiplas saídas com base em múltiplas entradas.

2. O MÉTODO FORMAL DE AVALIAÇÃO DE EFICIÊNCIA DEA (DATA ANALYSIS ENVELOPMENT)

Os principais métodos formais para medir a eficiência envolvem os princípios de métodos paramétricos e não paramétricos. Nos dois casos, o objetivo principal é estimar uma fronteira de eficiência que represente a melhor prática produtiva e calcular os índices de eficiência em relação a essa fronteira. Os métodos paramétricos supõem uma relação funcional predefinida entre os recursos e o que foi realmente produzido. Os métodos não paramétricos, por sua vez, impõem menos restrições à tecnologia de produção em determinada unidade. Estes métodos baseiam-se na ideia de envolver os dados observados para constituição da fronteira de eficiência mediante técnicas de programação matemática.

Para utilizá-los, não é preciso especificar nenhuma suposição funcional, pois trabalham com a suposição de que a probabilidade de as observações estarem além da fronteira do conjunto de produção é nula e que o máximo que poderia ter sido produzido é obtido por meio da observação das unidades mais produtivas. Do ponto de vista econômico, os métodos não paramétricos impõem que qualquer desvio da organização em relação à fronteira produtiva decorre unicamente de ineficiência desta em relação à posição da fronteira de produção.

O Gráfico 1 ilustra a projeção da fronteira de eficiência. Referido exemplo apresenta uma função de produção, em que x representa o insumo (input) e y significa o produto (output). A máxima quantidade de produto que a utilização de x pode gerar é representada por f(x), ou seja, a função de produção ou fronteira de eficiência. Nota-se que o ponto C, situado abaixo da fronteira, indica uma região factível de produção. Esse ponto significa, porém, que se está empregando OE unidades de x para produzir OA unidades de y. Ao operar abaixo da fronteira, esse plano de produção é considerado ineficiente, pois, dada a tecnologia disponível, não se empregam da melhor forma os recursos.

Gráfico 1. Fronteira de eficiência

Fonte: Souza Junior; Gasparini (2006, pp. 805)

Por outro lado, o ponto B é dito eficiente, já que produz a mesma quantidade de output utilizando a menor quantidade de input possível. O ponto D também representa um plano de produção tecnicamente viável e eficiente, com o qual se obtém o máximo de output, utilizando a mesma quantidade de input. A unidade ineficiente C precisa caminhar até o ponto B se quiser se tornar eficiente reduzindo recursos. No entanto, se preferir aumentar os produtos, tem que caminhar até o ponto D.

Um dos métodos de construção de fronteira de eficiência mais utilizados na análise da eficiência do setor público tem sido o Data Envelopment Analysis – DEA (AFONSO, 2007, pp.112). Com base na avaliação da eficiência proposta por Farrel (1957), que considerou um só insumo e apenas um produto, Charnes, Cooper e Rhodes (1978) iniciaram o estudo da abordagem não paramétrica para análise de eficiência com múltiplos insumos (inputs) e múltiplos produtos (outputs). E, com a utilização de programação linear, operacionalizaram o método de eficiência de Farrel (1957) e o denominaram de Data Envelopment Analysis (DEA), ou Análise Envoltória de Dados.

Vilela; Nagano; Merlo (2007, pp. 111) aceitam o fato de que a Análise Envoltória de Dados (DEA - Data Envelopment Analysis) é um dos principais métodos de fronteira, principalmente pela facilidade de caracterizar as unidades eficientes ou ineficientes tecnicamente, além de identificar as variáveis que podem ser trabalhadas para a melhoria do resultado de qualquer unidade do sistema.

Charnes, Cooper; Rhodes (1978) denominaram as unidades de produção de unidades tomadoras de decisão (decision making units – DMU). Essas unidades podem ser de qualquer natureza, por exemplo, países, organizações, unidades departamentais ou pessoas, operações ou processos. As DMU´s devem pertencer a um conjunto homogêneo, sendo que cada DMU possui um conjunto de inputs e outputs, representado por múltiplas medidas de desempenho. Considerando um conjunto de n DMUa, cada DMUj (j = 1, ..., n) usa m inputs xij (i = 1, ..., m) para produzir s outputs yrj (r = 1, ..., s).

Uma DMU é eficiente, se nenhuma outra DMU (ou combinações de DMU´s) no conjunto de referência produz maior output com igual nível de input, ou se nenhuma DMU no conjunto de referência produz o mesmo nível de outputs (ou mais), enquanto consome menor quantidade de input (VILELA; NAGANO; MERLO, 2007).

O método DEA permite analisar a eficiência relativa por dois canais distintos: orientação a input, que visa à minimização dos fatores de produção (insumos), mantendo um nível fixo de produção; e orientação a output, no qual se busca a maximização do nível de produção, mantendo os insumos fixos. Para um índice de eficiência igual a 1, indica que a DMU (Unidade Tomadora de Decisão) analisada é eficiente. Qualquer uma dessas formas pode analisar inúmeros inputs e ouptuts, para produzir um ranking de eficiência relativa e, dessa forma, possibilitar a criação um conjunto de opções nas decisões administrativas (ALENCASTRO; FOCHEZARRO, 2006).

Desde o surgimento do método DEA, vários modelos foram introduzidos à sua versão original, dentre os quais se destaca o modelo BCC (Banker; Charnes; Cooper, 1984), com retorno variável de escala, abrangendo as duas opções de abordagem: orientação para input ou orientação para output. A ideia do modelo BCC, desenvolvido por Banker; Charnes; Cooper (1984) é observar como mudanças proporcionais no conjunto de inputs refletem em termos de mudança no conjunto de outputs. Pode haver uma situação de retornos crescentes de escala, quando uma mudança nos inputs leva a uma mudança mais do que proporcional nos outputs. Inversamente, pode haver também a situação de retornos decrescentes de escala.

O modelo BCC, orientado a input, minimiza os inputs e mantém os outputs em seus níveis correntes, com possibilidades de retornos variáveis de escala. O modelo BCC, orientado a output, maximiza os outputs e mantém os inputs em seus níveis correntes, admitindo retornos variáveis de escala. Segundo Zhu (2009), os valores obtidos para a eficiência técnica, com a pressuposição de retornos variáveis, são maiores do que aqueles obtidos com retornos constantes. Se uma DMU é eficiente no modelo CCR, então ela é eficiente no modelo BCC.

Uma das principais vantagens do modelo de fronteira é a sua habilidade em avaliar a eficiência relativa de unidades com base em múltiplas entradas e múltiplas saídas. Essa característica permite melhor compreensão das causas que estão proporcionando as alterações de produtividade nas unidades em análise. Por essa razão, eles são particularmente apropriados às aplicações em setores com processos complexos, tais como as universidades, onde existe carência de informações sobre preços e custos operacionais como critérios para avaliar o desempenho de cada unidade de tomada de decisão.

3. AVALIAÇÃO DOS CURSOS DE GRADUAÇÃO ATRAVÉS DO USO DO DEA

Em virtude da avaliação dos cursos de graduação da UFC investigar fatos observados no período de 2006 a 2009 registrados na instituição, e diagnosticar dados da gestão acadêmica, analisando os indicadores de eficiência relativa e fazendo uso de modelos estatísticos, classifica-se, portanto, como uma pesquisa do tipo quantitativa. Do ponto de vista de seus objetivos, caracteriza-se como exploratória e descritiva, de corte longitudinal, onde são observadas e descritas as tendências ao longo de um período preestabelecido numa topologia comparativa. Quanto aos procedimentos técnicos para a coleta de dados, trata-se de um estudo de caso, além de ex-post facto, pois os dados trabalhados são oriundos de fatos observados na unidade em análise.

Para aplicação e implementação do modelo DEA, existem três fases principais (VILELA; NAGANO; MERLO, 2007). São elas: definição e seleção das DMU´s a entrarem na análise; seleção dos fatores (inputs e outputs) que são relevantes e apropriados para estabelecer a eficiência relativa das DMU´s selecionadas, e definição e aplicação do modelo DEA. Essas etapas são descritas a seguir.

3.1. Definição e seleção das DMU´s

As DMU’s, representam operações de negócios ou processos, caracterizadas como uma entidade responsável pela transformação de insumos em produtos. Então, cada DMU possui um conjunto de variáveis de inputs (insumos) e outputs (produtos), representado por múltiplas medidas de desempenho. Nessa etapa de implementação do modelo DEA, portanto, são estabelecidos o universo e a amostra da pesquisa.

3.1.1. Universo e amostra de DMU

Considerando a necessidade do conjunto de DMU ser homogêneo, e levando em conta que o processo de ensino-aprendizagem é havido como estratégico para a instituição, por agregar valor específico ao aluno, definimos como unidades de análise os cursos de graduação da Universidade Federal do Ceará, caracterizando-se como universo da pesquisa.

Os critérios utilizados para a seleção e definição da amostra do tipo intencional foram os seguintes:

- o curso de graduação ser sediado em Fortaleza, e possuir alunos concludentes no período de 2006 a 2009;

- a unidade acadêmica a que o curso se encontra vinculado deverá ter registrado os seus planos departamentais na CPPD - Comissão Permanente de Pessoal Docente – durante o período em estudo, a fim de possibilitar a disponibilização das informações necessárias e suficientes para o desenvolvimento do ensaio.

- deve haver disponibilidade de informações necessárias ao desenvolvimento da pesquisa.

Concluindo os ajustes do levantamento de dados dos cursos que apresentavam problemas de inconsistência, foram selecionados e definidos 30 cursos de graduação, conforme relacionados a seguir:

- Centro de Ciências: Ciências Biológicas, Geografia, Geologia, Química e Química Industrial;

- Centro de Ciências Agrárias: Agronomia, Economia Doméstica, Engenharia de Pesca, Engenharia de Alimentos, Estilismo e Moda, e Zootecnia;

- Centro de Humanidades: Comunicação Social, Letras e Psicologia;

- Centro de Tecnologia: Arquitetura, Engenharia Civil, Engenharia de Produção Mecânica, Engenharia Elétrica, Engenharia Mecânica e Engenharia Química;

- Faculdade de Economia, Administração, Atuária e Contábeis (FEAAC): Administração, Ciências Atuariais, Ciências Contábeis, Ciências Econômicas, e Secretariado;

- Faculdade de Direito: Direito

- Faculdade de Farmácia, Enfermagem e Odontologia (FFEO): Farmácia , Enfermagem e Odontologia.

Vale a pena salientar que os resultados do DEA são sensíveis ao tamanho da amostra (DMU´s) e às especificações de fatores de inputs e outputs. É importante que haja um equilíbrio entre a definição da quantidade de DMU´s e a quantidade de fatores a serem analisados pelo modelo. Torna-se essencial, após os resultados da análise exploratória de dados e a definição das DMU´s, o entendimento da seleção dos fatores de inputs e outputs atribuídos as DMU´s especificadas.

3.2. Seleção dos fatores de inputs e outputs das DMU

Para a seleção das variáveis, decidimos, portanto, escolher dentre aquelas diretamente relacionadas ao processo de ensino-aprendizagem dos cursos de graduação da UFC. Tais variáveis são, efetivamente, as mais representativas para uma eficiente medição de performance, tendo como base o alcance dos objetivos estratégicos da instituição, levando-se em consideração a disponibilidade das informações dos cursos no período de 2006 a 2009.

Tendo em vista os indicadores existentes como objetivos estratégicos e a disponibilidade de acesso às informações acadêmicas na instituição, definimos, inicialmente, uma lista de 14 variáveis, subdivididas em insumos (inputs) e produtos (outputs) das DMU´s selecionadas. Dadas as limitações expostas, a lista inicial de fatores teve que ser reduzida, incluindo somente aqueles efetivamente relevantes. Para isso, levamos em consideração os seguintes questionamentos para a seleção dos fatores.

- O fator selecionado contribui para um ou mais do conjunto dos objetivos estabelecidos para a análise da eficiência na produção acadêmica dos cursos de graduação da UFC?

- O fator expressa informações pertinentes não incluídas em outros fatores?

- Os dados são prontamente disponíveis e confiáveis?

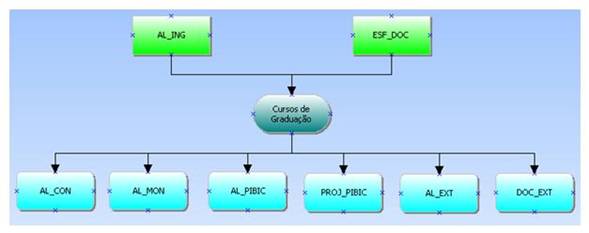

Assim sendo, definimos uma lista final para o modelo DEA, resultando em oito indicadores, sendo dois indicadores de insumos (inputs) e seis de produtos (output), considerados mais representativos para os cursos de graduação da Universidade Federal do Ceará, conforme mostra a Figura 2. Esses indicadores são discriminados a seguir.

Como INSUMOS (Inputs), foram definidos os seguintes indicadores:

AL_ING (Número de alunos ingressantes) - representa a quantidade total de alunos admitidos, via vestibular, no curso de graduação.

ESF_DOC (Esforço da capacidade de docentes) - Corresponde a um valor calculado com base na carga horária de professores efetivos, substitutos ou visitantes, vinculados ao curso, considerando as titulações de doutor, mestre, especialista e graduado. O esforço da capacidade de docente é definido como:

Como PRODUTOS (Outputs), foram definidos os seguintes indicadores:

AL_CON (Número de concludentes) - Corresponde à quantidade de alunos formados no curso de graduação, que ingressaram via vestibular.

AL_MON (Quantidade de alunos em monitoria)

AL_PIBIC (Quantidade de alunos em PIBIC)

PROJ_PIBIC (Quantidade de projetos PIBIC)

AL_EXT (Quantidade de alunos em extensão)

DOC_EXT (Quantidade de docentes em extensão)

Os dados quantitativos dos indicadores foram provenientes da Pró-Reitoria de Planejamento, Pró-Reitoria de Extensão, Pró-Reitoria de Pesquisa e Pós-Graduação, bem como da base de dados disponibilizada pela Pró-Reitoria de Graduação e pelo Núcleo de Processamento de Dados. Também foram extraídas informações dos planos departamentais registrados na Comissão Permanente de Pessoal Docente (CPPD), especificamente para compor o indicador que expressa o esforço necessário em termos de horas-aulas ministradas ao curso em análise, conforme com a titulação da capacidade docente.

Figura 2. Modelagem do método DEA

Fonte: Elaboração própria, utilizando o Frontier Software Analyst

3.3. Definição e aplicação do modelo DEA

O modelo DEA definido para o desenvolvimento deste trabalho foi o BCC (Banker; Charnes; Cooper) ou VRS (Variable Returns to Scale), assumindo, assim, casos de rendimentos variáveis de escala. Tal escolha se justifica por defendermos o pressuposto de que a expansão dos produtos gerados nos cursos de graduação, alunos diplomados com bom desempenho acadêmico, nem sempre está diretamente proporcional à expansão dos insumos ou recursos. Além disso, optamos pela orientação do modelo voltada para o produto por ser mais adequado a análise, pois tal modelo fornece um escore de eficiência que indica a máxima expansão de que a produção pode ser alvo, ao se fixar um nível de consumo de insumos; pela própria natureza de serviço público da Universidade sob análise, cujo principal insumo não pode ser minimizado, pois os professores, por exemplo, são os maiores responsáveis para que um determinado curso alcance seus objetivos de eficiência.

4. RESULTADOS E DISCUSSÃO

Para a análise de dados deste estudo, aplicamos, inicialmente, a Estatística Descritiva, observando os valores máximos, mínimos, média e desvio-padrão do conjunto de indicadores, além do uso da técnica de análise de correlação de Pearson para a investigação do relacionamento entre as variáveis, numa interpretação longitudinal, visando à constituição de uma série histórica, de 2006 a 2009, conforme mostra a Tabela 1.

Os valores mínimos e máximos da variável AL_ING (quantidade de alunos ingressantes) se mantiveram constantes entre 2006 e 2009. Isso caracteriza uma dispersão na distribuição dos escores, além de poucas alterações na quantidade de alunos ingressantes no período em que, de acordo com a duração-padrão da Secretaria de Educação Superior do Ministério da Educação, estariam concluindo o curso de graduação no período em análise.

Tabela 1. Análise Estatística dos Indicadores das DMU´s (Modelo DEA)

_art17_tabela1.jpg)

Ao comparar o coeficiente de variação, o qual mostra o desvio-padrão expresso como uma porcentagem média, observamos que os maiores percentuais de variação relativa do conjunto de observações que diferem da média estão concentrados nas ações de extensão, tanto com a quantidade de alunos como a quantidade de docentes, sendo que, em 2007, essa concentração passou para a quantidade de docentes em extensão (207,7%) e a quantidade de alunos em projetos de pesquisa do tipo PIBIC (106,2%).

Embora o indicador que expressa o Esforço da Capacidade de Docentes (ESF_DOC) apresente uma distância relativamente pequena entre o seu valor mínimo e máximo (0,2 a 0,5), vale a pena ressaltar que esse valor representa um índice que varia de 0 a 1. Dessa forma, podemos garantir que há existência de um ambiente heterogêneo em relação à força de trabalho de docentes nos diferentes cursos. Esses dados deixam claro que existem cursos necessitados de um esforço maior em comparação com os demais, no que diz respeito à relação entre a carga horária e a titulação de seus professores, embora façam parte da mesma instituição. Seus desvios-padrão, todavia, são relativamente grandes, sinônimo de variâncias também bastante expressivas. Isto explica os valores mínimos e máximos observados.

Constatamos que, em média, a quantidade de alunos concludentes está muito abaixo da quantidade de alunos ingressantes, durante todo o período analisado. A situação é agravada pelo fato de que esses valores médios estão diminuindo, ano a ano. A fim de eliminar redundâncias, realizamos um estudo de correlação entre as variáveis por meio do coeficiente de correlação de Pearson, obtendo resultados comparativos entre os indicadores que representam pontos de acumulação. Ficou estabelecido que, quando o coeficiente de correlação entre uma variável de insumo (input) e uma variável de produto (output) atinge um valor acima de 0,95, indica que uma das variáveis deve ser descartada. A Tabela 2 mostra o resultado das correlações entre os fatores de insumo (inputs) e os fatores de produto (outputs).

Tabela 2. Correlação entre os indicadores de input e output dos cursos de graduação (Modelo DEA)

Input |

2006 |

2007 |

2008 |

2009 |

||||

Output |

AL_ING |

ESF_DOC |

AL_ING |

ESF_DOC |

AL_ING |

ESF_DOC |

AL_ING |

ESF_DOC |

AL_CON |

0,84 |

-0,04 |

0,87 |

0,14 |

0,89 |

0,25 |

0,90 |

0,37 |

AL_MON |

0,44 |

-0,26 |

0,19 |

-0,32 |

0,43 |

-0,30 |

0,61 |

-0,09 |

AL_EXT |

-0,13 |

-0,32 |

0,45 |

-0,35 |

0,07 |

-0,28 |

0,11 |

-0,21 |

DOC_EXT |

0,06 |

-0,37 |

0,11 |

-0,21 |

0,00 |

-0,40 |

0,15 |

-0,21 |

AL_PIBIC |

0,09 |

-0,51 |

0,10 |

-0,47 |

0,20 |

-0,42 |

0,29 |

-0,30 |

PROJ_PIBIC |

0,16 |

-0,57 |

0,09 |

-0,45 |

0,23 |

-0,46 |

0,30 |

-0,31 |

Fonte: Elaboração própria

Com este estudo, evidenciamos alguns fatos, considerados relevantes, como o esforço da capacidade de docente (ESF_DOC), que apresentou correlação negativa entre todos os indicadores de produtos (outputs), à exceção da correlação entre a quantidade de alunos concludentes (ALU_CON) referente aos anos de 2007 a 2009. Mesmo assim, essa correlação, apesar de positiva, ainda foi muito baixa. Esses dados demonstram, entretanto, um crescimento, partindo de r = -0,04 em 2006 e aumentando para r = 0,14 em 2007, r = 0,25 em 2008 e chegando a r = 0,37 em 2009.

Estes resultados positivos para o grau de correlação revelam que, à medida que a quantidade de carga horária de professores com alta titulação aumenta, tende a diminuir (em média) a quantidade de alunos formados, levando a crer que a preferência dada pela instituição por professores doutores não está refletindo no desempenho do ensino de graduação, mas, principalmente, nas atividades de pesquisa do tipo PIBIC, uma vez que exibiram a mais alta correlação negativa.

A fim de facilitar a percepção da sensibilidade dos escores de eficiência relativa em virtude da inclusão de novos indicadores, optamos por apresentar as medidas de eficiência organizadas em abordagens, sendo que cada abordagem engloba determinado tipo de indicador, sendo classificada da seguinte forma:

- A1 eficiência de concludentes – mostra os escores de eficiência levando-se em consideração os dois fatores de inputs (AL-ING e ESF_DOC) e um único fator de output, a quantidade de alunos concludentes (AL_CON);

- A2 eficiência de concludentes e monitoria – demonstra os resultados da eficiência ao ser acrescentado no modelo de eficiência de concludentes (item anterior) mais um fator de output, o fator que expressa a quantidade de alunos em monitoria (AL_MON);

- A3 eficiência de concludentes, monitoria e extensão – exibe os resultados do cálculo da eficiência ao ser incluído mais outro fator de output no modelo de eficiência de concludentes e Monitoria (item anterior), a quantidade de alunos e docentes envolvidos em ações de extensão (AL_EXT e DOC_EXT). Nesse caso, a eficiência leva em consideração os dois fatores de inputs (AL_ING e ESF_DOC) e os quatro fatores de outputs (AL_CON, AL_MON, AL_EXT e DOC_EXT); e

- A4 eficiência de concludentes, monitoria, extensão e PIBIC – expressa o resultado geral da aplicação do modelo DEA referente aos dados de 2006 a 2009, onde são analisados os dois fatores de inputs (AL_ING e ESF_DOC) e os seis fatores de outputs (AL_CON, AL_MON, AL_EXT, DOC_EXT, AL_PIBIC e DOC_PIBIC).

O resultado, em valores percentuais, do cálculo da eficiência relativa obtido pelas DMU´s, nos anos de 2006 a 2009, analisadas com a aplicação do método BCC-O e organizadas por abordagem de indicadores de output é apresentado no Apêndice A. As unidades que alcançaram em seus resultados valores abaixo de 80% dos produtos gerados pela unidade de melhor prática observada estão com os seus valores de eficiência destacados em vermelho. Aquelas que atingiram valores de eficiência entre 80% e 99% se encontram escritas em laranja, indicando que estão perto de se tornarem 100% eficientes. E as unidades que atingiram 100% de eficiência relativa estão escritas em verde.

Considerando a aplicação da modelagem completa do método DEA, com ênfase nos indicadores de Alunos concludentes, monitoria, extensão e PIBIC (abordagem A4), durante o período de 2006 a 2009, os resultados mostram que existe um grupo de nove DMUs (30% dos cursos analisados) que permaneceram, ao longo do tempo, no nível máximo de eficiência. De forma análoga, constatamos que há um grupo de cinco DMUs que, ao longo do tempo, permaneceu sempre ineficiente, com valores de eficiência relativa abaixo de 80%.

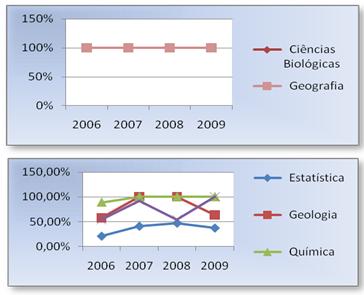

Com relação ao Centro de Ciências, os cursos de Ciências Biológicas e Geografia se destacam com alta eficiência durante todo o período. Em contrapartida, conforme exprime o Gráfico 2 o curso de Estatística se manteve na categoria de muito baixa eficiência ao longo do tempo (20,9%, em 2006; 40,5%, em 2007; 46,6%, em 2008; 37%, em 2009).

É notável, ainda, uma oscilação nos resultados do cálculo da eficiência relativa do curso de Geologia, que, em 2006, foi considerado com baixa eficiência (57,9%), mas, nos dois anos seguintes, em 2007 e 2008, alcançou 100% de eficiência, apresentando, porém, uma queda em seus resultados em 2009, voltando para a categoria de baixa eficiência (63,3%). Já o curso de Química mostrou equilíbrio em seus resultados, pois não só atingiu o grau de alta eficiência no ano de 2006, como também chegou próximo do nível máximo de eficiência (88,3%). Portanto, dos seis cursos do Centro de Ciências, quatro deles foram considerados de alta eficiência em 2009, demonstrando superação e alcance de bons resultados.

Gráfico 2. Eficiência relativa dos cursos do Centro de Ciências (2006 – 2009)

Fonte: Elaboração própria

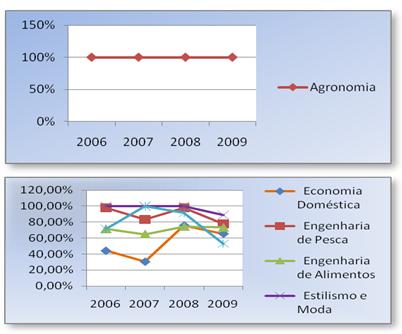

Com relação ao Centro de Ciências Agrárias, apenas um de seus cursos, Agronomia, foi considerado com alta eficiência durante todo o período analisado. O curso de Estilismo e Moda foi considerado com eficiência máxima (100%) até o ano de 2008, mas, em 2009, houve uma queda do valor de eficiência para 88,8%, passando para a categoria de média eficiência (ver Gráfico 3).

Gráfico 3. Eficiência relativa dos cursos do Centro de Ciências Agrárias (2006 – 2009)

Fonte: Elaboração própria

Os cursos de Zootecnia e Engenharia de Pesca demonstram um declínio em seus resultados de eficiência, uma vez que, a cada ano, é observada uma diminuição no valor de eficiência, passando da faixa de alta eficiência para média eficiência, ou seja, inferior a 91% e superior a 80%. Constatamos, portanto, que, dos seis cursos que compõem o Centro de Ciências Agrárias, apenas um deles foi considerado eficiente e dois ineficientes durante o período analisado, enquanto os demais cursos demonstraram a existência de um declínio nos resultados quanto ao desempenho de eficiência no decorrer do período analisado.

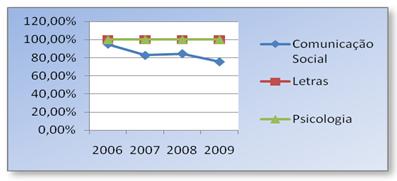

Quanto aos cursos do Centro de Humanidades, dois deles (Letras e Psicologia) se mantiveram numa situação de 100% de eficiência durante todo o período analisado (ver Gráfico 4) ; no entanto, o Curso de Comunicação Social apresenta uma redução no seu nível de eficiência, passando da proximidade do nível de eficiência alta para a faixa de baixa eficiência. Ainda se mantém, entretanto, na faixa de média eficiência (75,6%).

Gráfico 4. Eficiência relativa dos cursos do Centro de Humanidades (2006–2009)

Fonte: Elaboração própria

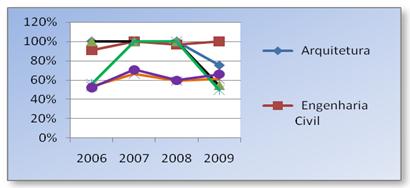

No que diz respeito ao Centro de Tecnologia, nenhum de seus cursos foi considerado com eficiência máxima durante todo o período analisado, apesar de o curso de Arquitetura haver exibido tal resultado de 2006 a 2008, mas especificamente, em 2009, passou para 75,2% de eficiência, valor este que o classifica como ineficiente. O curso de Engenharia Civil se manteve sempre com alta eficiência (acima de 90%) e, em 2007 e 2009, atingiu 100% de eficiência. Os cursos de Engenharia Química e Engenharia Elétrica foram considerados com baixa eficiência durante todo o período analisado (ver Gráfico 5).

Gráfico 5. Eficiência relativa dos cursos do Centro de Tecnologia (2006 – 2009)

Fonte: Elaboração própria

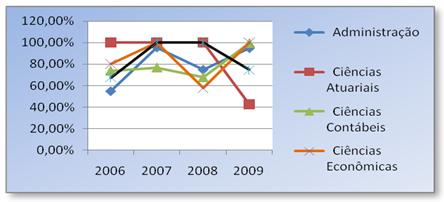

Na Faculdade de Economia, Administração, Atuária e Ciências Contábeis (FEAAC), destaca-se o curso de Ciências Atuariais, que vinha se mantendo com alta eficiência durante o período de 2006 a 2008, mas, em 2009, registrou uma diminuição significativa no nível de eficiência, passando para 42,6% (ver Gráfico 6). Em contrapartida, o curso de Ciências Econômicas mostrou oscilação significativa no grau de eficiência, passando de 80,3% em 2006 para 100% em 2007; em seguida, em 2008 baixou para 55,8% e, em 2009, retornou ao índice máximo de eficiência (100%). Dos cinco cursos analisados, nenhum deles se mostrou com alta eficiência durante todo o período, mas a Faculdade demonstra uma situação de melhoria nos demais cursos, no último ano analisado.

Gráfico 6. Eficiência relativa dos cursos da FEAAC (2006 – 2009)

Fonte: Elaboração própria

Quanto à Faculdade de Direito e a Faculdade de Farmácia, Odontologia e Enfermagem (FFOE), constatamos que os seus cursos permaneceram, ao longo do tempo, no nível máximo de eficiência.

Em suma, os resultados de eficiência relativa referente à abordagem 4 (A4), revelam que, em média, 15,75 cursos por ano, ou seja, 52,5% dos 30 cursos analisados, foram considerados eficientes. Comparando-se os resultados do cálculo da eficiência relativa entre as diferentes abordagens, conforme é apresentado no Apêndice B, notamos que à medida que se vão acrescentando os indicadores no que diz respeito à monitoria, ações de extensão e projetos de pesquisa do tipo PIBIC para o cálculo de eficiência pelo método DEA, os cursos tendem a apresentar melhores resultados, comprovando que o desenvolvimento de tais atividades, quando analisadas em conjunto com a quantidade de alunos concludentes, representa a quantidade máxima de resultados alcançados pelos cursos observados.

Em contrapartida, analisamos a eficiência levando em consideração apenas o indicador que representa a quantidade de alunos concludentes, os resultados mostram baixo desempenho de eficiência dos cursos de graduação da UFC. Ressaltemos que 2009 foi o ano a apresentar a menor quantidade de cursos eficientes durante o período analisado.

Além disso, ao confrontarmos a quantidade de horas/aula ministradas por professores doutores, mostradas nos Apêndices A, B, C e D, com os cursos que atingiram valor percentual de eficiência relativa menor do que 80%, pelo método DEA, durante 2006 a 2009, os resultados revelam que, no mínimo, 50% deles possuíam carga horária de professores doutores mais elevada do que os demais, com titulação de mestre, especialista e graduado (ver Apêndice C). Em 2006, dentre os 12 cursos considerados com eficiência relativa menor do que 80%, seis deles (50%) constam com maior número de horas/aula ministradas por professores doutores.

Em 2007, o método DEA considerou seis cursos com percentual de eficiência menor do que 80%, mas três deles possuíam a carga horária mais elevada de professores doutores, perfazendo, assim, um percentual de 50%. Em 2008, foram nove cursos e seis deles (66,7%) apresentaram maior carga horária de professores doutores. Em 2009, foram 14 cursos, sendo nove (64,3%) com maior número de horas/aula de professores doutores.

Dessa forma, menos da metade da quantidade de cursos que alcançaram o percentual de eficiência relativa menor do que 80%, durante o período de 2006 a 2009, apresentam menor quantidade de horas-aula sendo ministradas por professores doutores em relação às demais titulações (mestres, especialistas e graduados), pois em 2006 e 2007, 50% dos cursos apresentavam menor carga horária de professores doutores, em 2008, apenas 33,3% e, em 2009, foram 35,7%.

Notamos, também, que, dentro de uma mesma unidade acadêmica, existem cursos que foram considerados, pela técnica DEA, como eficientes e outros não eficientes, como, por exemplo, no Centro de Ciências, em cada ano analisado, restou demonstrada uma grande variação do grau de eficiência entre seus cursos (ver Apêndice D).

Em busca de melhores práticas nos cursos de graduação da UFC que conduzem a um desempenho superior, convém realizar análise de benchmark, identificando, inicialmente, o conjunto de unidades de referência de uma unidade considerada ineficiente, ou seja, os cursos eficientes considerados parceiros de excelência para os ineficientes, na tentativa de estender os procedimentos mais eficazes, que conduzem a um desempenho superior.

4.1. Análise de benchmarks ou parceiros de excelência

Comparar a eficiência de unidades organizacionais pode ajudar a avaliar os seus desempenhos em relação às outras unidades. Se uma organização é eficiente, ela utiliza seus recursos (inputs) para alcançar a máxima produção (output). Dado um certo mix de inputs, a eficiência é determinada comparando-se o output observado aos máximos outputs possíveis conseguidos por outras unidades

observadas.

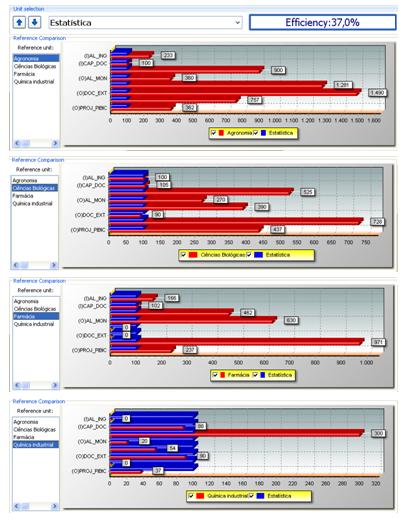

Gráfico 7. Comparação do curso de Estatística com suas unidades de referência

Fonte: Dados extraídos do software Frontier Analyst

Assim, os inputs da DMU ineficiente precisam se referenciar aos inputs das DMU´s eficientes, utilizadas como benchmark, para que ela possa alcançar a eficiência, mantendo os atuais níveis de outputs. Para isso, comparamos o que foi produzido, dados os recursos disponíveis, com o que poderia ter sido produzido com os mesmos recursos.

Para cada unidade ineficiente observada, o método DEA identifica um conjunto de unidades eficientes que possuem recursos (inputs) e resultados (outputs) mais semelhantes com a unidade ineficiente para formar seu grupo de referência para o benchmark. O Apêndice E apresenta a análise de benchmarking das unidades consideradas ineficientes durante o período de 2006 a 2009, por ordem decrescente de sua posição no ranque de eficiência em relação a 30 unidades analisadas, especificando o conjunto de DMU´s eficientes usadas como referência para que cada DMU ineficiente possa se tornar eficiente.

No Gráfico 7, é possível visualizar uma comparação dos fatores definidos como inputs e outputs da unidade ineficiente, o que pode conduzir à percepção, de forma clara, dos domínios de ineficiência do curso de Estatística, em relação as suas unidades de referência (cursos de Agronomia, Ciências Biológicas, Farmácia e Química Industrial). As barras que representam as unidades de referência são apresentadas na cor vermelha e as tomadas como base para comparação, ou seja, as unidades ineficientes, são representadas em azul.

Percebe-se, portanto, que o curso de Ciências Biológicas está com o mesmo número de ingressantes do Curso de Estatística e com apenas 5% a menos de esforço de docente, alcançando valores significativamente mais altos nos resultados em quase todos os fatores de outputs, com exceção apenas da quantidade de docentes em extensão. No caso, o curso de Ciências Biológicas apresenta 10% a menos do que o curso de Estatística. Em contrapartida, atinge valor de mais de 425% em alunos concludentes, 170% em alunos em monitoria, 390% em alunos em extensão, 628% em alunos em projetos PIBIC e 337% de projetos PIBIC.

O resultado de tal comparação deve levar a uma investigação sobre o “porquê” do curso de Ciências Biológicas ser capaz de alcançar resultados muito maiores, funcionando com quase o mesmo nível de inputs que utiliza o curso de Estatística. Sugerimos, portanto, estudo mais aprofundado e individualizado, no qual sejam investigados a influência de fatores tais como: o perfil do aluno ingressante e o modelo da gestão do curso.

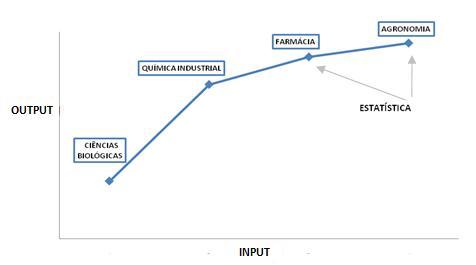

O conjunto de referência, formado pelas DMU´s eficientes, definem a fronteira de eficiência do conjunto observado. O Gráfico 8 apresenta, de forma ilustrativa e esclarecedora, a posição do curso de Estatística em comparação aos seus parceiros de excelência. Nesse caso, o curso de Estatística precisará caminhar até o ponto do curso de Agronomia se quiser tornar-se eficiente, aumentando os seus outputs.

Embora os quatro cursos apontados como unidades de referência possam ser utilizados como benchmark para o curso de Estatística, o método DEA mostra as folgas identificadas e traça metas para cada input/output, o que torna a DMU relativamente ineficiente. Esses valores projetados são gerados levando em consideração a menor distäncia que a DMU ineficiente pode percorrer para atingir a DMU eficiente.

Gráfico 8. Fronteira de eficiência em relação ao curso de Estatística, em 2009

Fonte: Adaptado de dados gerados pelo DEA-SOLVER

4.2. Metas projetadas para as DMU´s ineficientes

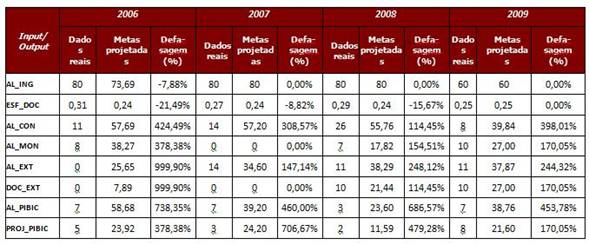

Ao analisar os cursos ineficientes em relação às metas sugeridas pela técnica DEA a cada um dos fatores definidos na modelagem, comprovamos que o curso de Estatística, de uma maneira geral, ao longo do período de 2006 a 2009, apresenta deficiência em quase todos os fatores de output em relação aos cursos que atingiram eficiência máxima. Além disso, constata-se, ainda, um superdimensionamento nos quantitativos dos fatores de input, causando assim uma defasagem entre os dados reais e as metas projetadas pelo método. Essa defasagem é apresentada na Tabela 3, com os seus valores arredondados em duas casas decimais, para facilitar a interpretação dos mesmos.

Tomando o ano de 2006 como referência, observamos em 2009 o fato de que as metas sugeridas pelo método DEA, no que diz respeito à diminuição, em termos percentuais, de 7,88% na quantidade de alunos ingressantes e de 21,49%, no esforço de docentes, foram alcançadas. Dessa forma, não ocorreu defasagem em suas quantidades. Com relação aos fatores de output, entretanto, o curso de Estatística não conseguiu êxito ao longo do período estudado. Houve aumento no percentual de defasagem em todos os fatores de output, dentre os quais, a quantidade de alunos envolvidos em projetos PIBIC é o fator que apresentou o maior percentual de defasagem (453,78%), seguido da quantidade de alunos concludentes (398,01%). O quantitativo de alunos em monitoria e de docentes em ações de extensão apresentou o menor percentual de defasagem (170,05%), contudo, ainda consideramos alto o grau de defasagem. Esses resultados demonstram que o curso de Estatística, mesmo dispondo de quantidades de recursos suficientes, ainda não conseguiu produzir resultados eficientes.

Tabela 3. Defasagem entre as metas projetadas e os dados reais de inputs/outputs no curso de Estatística (2006-2009)

Fonte: Adaptado dos dados gerados pelo DEA SOLVER

Dentre os 30 cursos analisados durante o período de 2006 a 2009, 21 apresentaram defasagem, em pelo menos um dos anos, entre as quantidades de alguns dos fatores de input e/ou output observados e os projetados pelo método DEA. Foram eles: Estatística, Economia Doméstica, Engenharia Química, Química Industrial, Engenharia Elétrica, Administração, Engenharia Mecânica, Geologia, Secretariado Executivo, Engenharia de Alimentos, Zootecnia, Ciências Contábeis, Ciências Econômicas, Química, Engenharia Civil, Comunicação Social, Engenharia de Pesca, Ciências Atuariais, Engenharia de Produção Mecânica, Arquitetura e Estilismo e Moda.

De maneira geral, não foram identificadas folgas no fator de input AL_ING dentre os 21 cursos identificados com defasagem, pois apenas no primeiro ano de análise (2006), foi identificada pequena defasagem, indicando que a quantidade de alunos ingressantes deveria ser reduzida nos cursos de Estatística (7,88%), Química (6,63%), Engenharia de Pesca (12,20%), Engenharia Civil (8,45%); Ciências Contábeis (6,63%) e Ciências Econômicas (17,94%), sendo que, ao longo do período, essa defasagem foi equilibrada e, nos anos seguintes (2007 a 2009), tais cursos mantiveram esse fator em equilíbrio com relação aos demais cursos analisados.

Somente os cursos de Economia Doméstica, Engenharia de Alimentos e Engenharia de Pesca apresentaram folgas com relação ao fator de input ESF_DOC durante todo o período analisado. Essas folgas representam a existência de desequilíbrio na distribuição de professores nos diferentes cursos de graduação da UFC. Seus valores, entretanto, são negativos, o que leva à interpretação da necessidade de redução do esforço de docentes, ou melhor, da necessidade de contratação de pessoal no quadro de docentes para conseguir reduzir esse esforço.

Constatamos, também, que dez cursos (Estatística, Economia Doméstica, Engenharia Química, Engenharia Elétrica, Administração, Engenharia Mecânica, Engenharia de Alimentos, Ciências Contábeis, Comunicação Social e Engenharia de Pesca) permaneceram com deficiência na quantidade de alunos concludentes, em todos os anos analisados, correspondendo a 33,33% dos cursos de graduação da UFC. Além disso, esses mesmos cursos permaneceram, também, com defasagem, tanto na quantidade de projetos do tipo PIBIC como na quantidade de alunos envolvidos em tais projetos, o que demonstra dificuldade no alcance das metas quanto à formação de alunos nos cursos de graduação e também quanto ao desenvolvimento de atividades de pesquisa do tipo PIBIC.

Somente os cursos de Estatística, Engenharia Mecânica, Ciências Contábeis, Comunicação Social e Engenharia de Pesca apresentaram, durante todo o período analisado, deficiências na quantidade de alunos envolvidos em atividades de extensão, levando à interpretação de que tais cursos não mostram relacionamento transformador entre a Universidade e a Sociedade. Vale a pena ressaltar o fato de que o curso de Estatística exibiu folga positiva ou negativa em quase todos os fatores analisados, incluindo inputs e outputs, com exceção dos seguintes aspectos: quantidade de alunos ingressantes em 2007, 2008 e 2009; quantidade de esforço de docentes em 2009; quantidade de alunos em monitoria e a quantidade de alunos em extensão, ambos em 2007.

5. CONSIDERAÇÕES FINAIS

O método DEA aplicado a essa pesquisa alcançou o objetivo principal, permitindo descrever o desempenho da eficiência produtiva dos cursos de graduação da UFC, durante o período analisado, fornecendo assim, subsídios quantitativos para que a instituição possa traçar metas, visando à melhoria global de sua produtividade.

Com base nas constatações desta pesquisa apresentamos algumas recomendações que poderão contribuir para o aprimoramento de trabalhos futuros e também servir de referência para as tomadas de decisões dos gestores da UFC, no sentido de corrigir possíveis distorções em alguns dos seus cursos de graduação. Dentre elas, destacam-se:

- aplicar o método DEA em todos os cursos da UFC, distribuídos em seus campi no Estado do Ceará; e

- incorporar variáveis qualitativas na modelagem do método DEA, uma vez que o mesmo possibilita a comparação em um sentido multidimensional na capacidade com que cada unidade tomadora de decisão, no caso os cursos de graduação, transforma seus insumos (inputs) em resultados (outputs).

É importante salientar o fato de que um processo de avaliação necessita ser permanente, dinâmico e sujeito a um contínuo aperfeiçoamento. Essa avaliação deve ser acompanhada em tempo real, em função da realidade atual constatada neste estudo longitudinal, no contexto do qual foram percebidas variações nos resultados de eficiência de um mesmo curso de um ano para o outro, comprovando, assim, que a realidade em determinado ano pode ser diferente da do ano anterior, mesmo sem grandes alterações em seus quantitativos de recursos e resultados gerados pelo curso. Isso se dá em decorrência da própria natureza do método DEA, o qual fornece a eficiência relativa, tomando como base os dados dos demais cursos em determinado momento. Desta maneira, sugerimos a construção de um software especializado na avaliação quantitativa da eficiência produtiva e qualidade dos cursos de graduação, pelo método DEA, e que esse software esteja integrado ao sistema informatizado da UFC.

Sugere-se, ainda, que a UFC examine, com mais precisão, as causas da variabilidade dos resultados apontados na avaliação da eficiência relativa dos cursos de graduação analisados, além de fazer um trabalho de conscientização e acompanhamento gerencial contínuo, por meio de reuniões periódicas e sistemáticas, com chefes de departamentos, coordenadores de cursos e diretores de unidades acadêmicas, de tal forma que venha a possibilitar o alinhamento das metas planejadas pela instituição com as ações desenvolvidas em seus cursos de graduação, acarretando, assim, melhoria contínua em seus resultados.

Acreditamos, pois, que este trabalho possa contribuir, efetivamente, para que a UFC desencadeie um processo de ação-reflexão sobre o fazer nos seus cursos de graduação por meio do método de Análise Envoltória de Dados (DEA), porquanto a instituição jamais empregou essa metodologia para a mensuração de eficiência produtiva com análise de benchmarking. Em adição, indicamos a busca de um conjunto de dados estratégicos conceitualmente claros e operacionalmente aplicáveis à avaliação institucional da UFC.

REFERÊNCIAS BIBLIOGRÁFICAS

Afonso, A. A Eficiência do Estado (2007). In: Boueri, R.; Saboya, M. (Orgs.) Aspectos do desenvolvimento fiscal, 2007, pp.111-124. Brasília: IPEA

Alencastro, L. D., Fochezatto, A. (2006). Eficiência Técnica na Gestão de Recursos em Instituições Privadas de Ensino Superior. Análise, 12 (2) pp. 234-242, Porto Alegre.

Andriola, W. (2004). Avaliação Institucional na Universidade Federal do Ceará (UFC): Organização de Sistema de Dados e Indicadores da Qualidade Institucional. Revista da Rede de Avaliação Institucional da Educacção Superior, 9 (4).

Balzan, N. C. (2008). A voz do estudante – sua contribuição para um processo de avaliação institucional. In: Balzan, N. C., Dias Sobrinho, J. (Orgs.). Avaliação Institucional teoria e experiências. pp. 115-147. São Paulo: Cortez.

Banker, R. D., Charnes, A., Cooper, W. W. (1984)Some models for estimating and scale in efficiencies. Management Science, 30 (9), pp. 1078-1092.

Farrel, M. J. (1957). The Measurement of Productive Efficiency. Journal of the Royal Statistical Society, Series A, 120 (3), pp. 253-281.

Firme, T. P. (1994). Avaliação: tendências e tendenciosidades. Ensaio: avaliação e políticas públicas em educação, 1 (2), pp.5-12. Rio de Janeiro.

Firme, T. P. (1997). Avaliação: um avanço no conhecimento. Revista Cesgranrio, 1, out.

Hall, R. (2006). Organizações: estruturas, processos e resultados. (Tradução) Galman. R. (Revisão Técnica) Guilherme Maximiano. 8. ed. São Paulo: Pearson/ Prentice Hall.

Kaplan, R. S, Norton, D.(2000). A Estratégia em Ação: Balanced Scorecard. Rio de Janeiro: Editora Campus.

OCDE (2002). Rumo a um desenvolvimento sustentável: indicadores ambientais (tradução de publicação da OECD – Organisation for Economic Co-operation and Development, por Ana Maria S. F. Teles). pp. 244. Salvador: Editora Centro de Recursos Ambientais

Scriven, M. (1991). Evaluation thesaurus. 4. ed. Newbury Park, CA: Sage.

Scriven, M.(2006). Relatório de Gestão - 2006. Fortaleza: Universidade Federal do Ceará. Acessado março 2010 em: http://www.ufc.br.

Scriven, M.(2007). Relatório de Gestão - 2007. Fortaleza: Universidade Federal do Ceará. Acessado março 2010 em: http://www.ufc.br.

Tachizawa, T., Andrade, R. O. (2006), Gestão de instituições de ensino. 4. ed. Rio de Janeiro: Editora FGV.

Vilela, D. L,, Nagano, M. S.; Merlo, E. M. (2007). Aplicação da Análise Envoltória de Dados em Cooperativas de Crédito Rural. RAC. 2. ed. Especial, pp.99-120.

Zhu, J. (2009). Quantitative Models for Performance Evaluation and Benchmarking – Data Envelopment Analysis with Spreadsheets and DEA Excel Solver. Series: International Series in Operatiosn Research and Management Science, 126, 2a. Ed. New York: Springer Science.

_art17_formula.jpg)